Capítulo 11 Introdução a testes de hipóteses

11.1 Filosofia da ciência

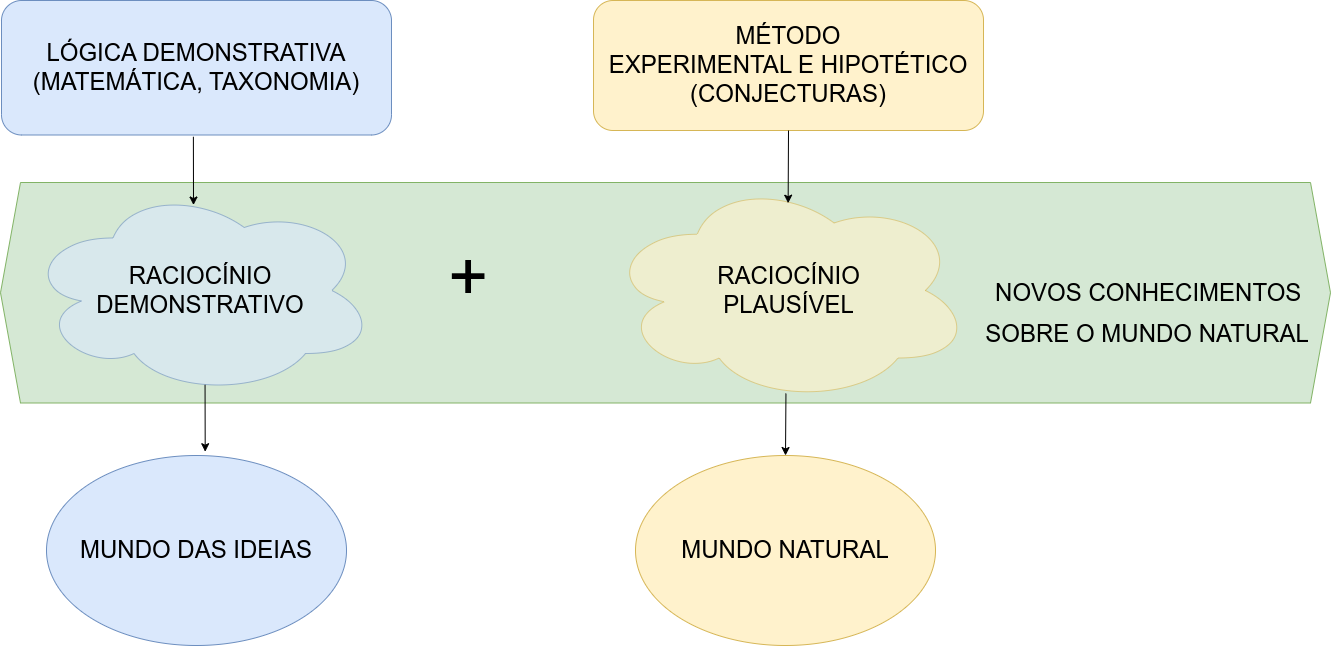

Estritamente falando, todo o conhecimento fora da matemática, da lógica demonstrativa (um ramo da mesma) e da taxonomia encontra-se fundamentado em hipóteses (naturalmente há inúmeros tipos de hipóteses, mas as que estamos a nos referir são altamente confiáveis, como as expressas em certas leis gerais da física e da química como, por exemplo, a Lei de Hooke as Leis de Kepler dentre tantas outras).

O raciocínio lógico demonstrativo permeia as ciências até onde a matemática lhe suporta; todavia, em si (assim como também a matemática), é incapaz de gerar novos conhecimentos sobre o mundo que nos rodeia.

O método lógico demonstrativo é próprio para objetos que existem apenas idealmente, que são construídos inteiramente pelo nosso pensamento.

O método hipotético experimental é próprio das ciências naturais (física, química, biologia, etc.), que observam seus objetos e realizam experimentos.

Figure 11.1: Método demonstrativo e Método experimental hipotético (George Polya, 1954)

Hipotético porque os cientistas partem de hipóteses sobre os objetos que guiam os experimentos e a avaliação dos resultados e experimental porque se baseia em observações e em experimentos, tanto para formular quanto para verificar as teorias.

O método hipotético experimental pode ser indutivo (fatos \(\to\) lei geral) ou dedutivo (lei geral \(\to\) fatos):

Hipotético-indutivo porque o cientista observa inúmeros fatos variando as condições da observação; elabora uma hipótese e realiza novos experimentos (ou induções) para confirmar ou negar a hipótese; se esta não for negada, chega-se à lei do fenômeno estudado.

Hipotético-dedutivo porque tendo chegado à lei, o cientista pode formular novas hipóteses, deduzidas do conhecimento já adquirido, e com elas prever novos fatos, ou formular novas experiências, que o levam a conhecimentos novos.

Em muitos processos de investigação científica é frequente ao pesquisador formular perguntas que deverão ser apropriadamente respondidas.

- comparar esses resultados a outros valores; ou,

- comparar resultados obtidos pela aplicação de diferentes métodos/ou produtos (valores centrais, variabilidade, proporções) observados em diferentes amostras.

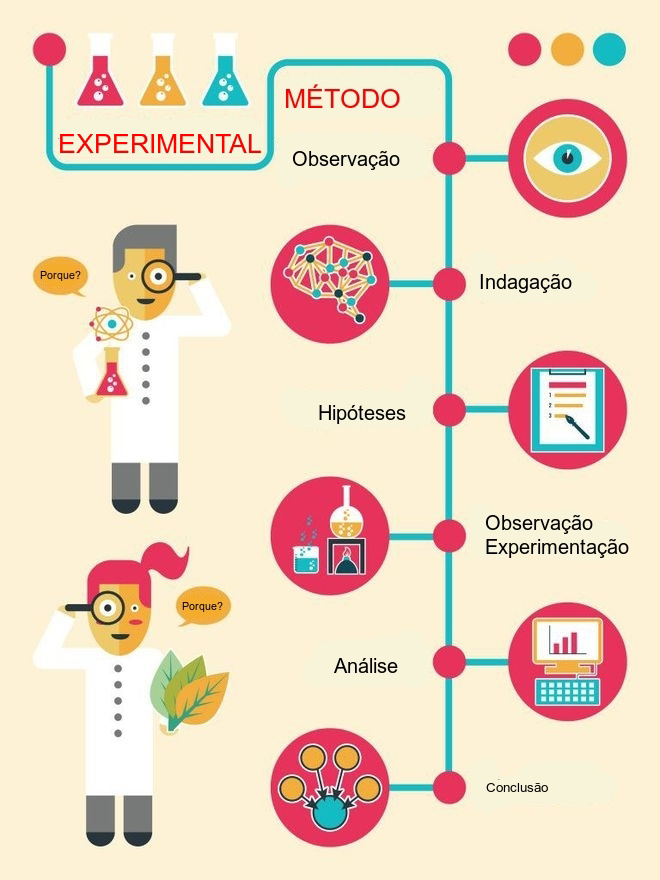

Figure 11.2: Método experimental hipotético

Uma hipótese é uma conjectura racional feita após um grande número de observações e experimentos; é uma tese que precisa ser confirmada ou verificada por meio de novas observações e experimentos.

Uma hipótese estatística é uma suposição feita sobre uma determinada característica de interesse de uma população sob estudo (um parâmetro) que subsiste (perdura, sobrevive, permanece incontestável) até que alguma informação sobre essa população seja estatisticamente significativa para contradizê-la.

``A ciência não consegue provar coisa alguma. Ela pode apenas refutar as coisas’’ (Karl Popper)

Uma teoria científica é, portanto, transitória. Uma conjectura temporariamente sustentada que um dia poderá ser refutada e substituída por outra. Conclusões baseadas em raciocínios plausíveis são provisórias, ao contrário daquelas produzidas por raciocínios lógico demonstrativos.

Um teste de hipóteses refere-se, portanto, a um método quantitativo subsidiário em processos de decisão, baseado na inferência estatística e de ampla aplicabilidade na experimentação e pesquisa; virtualmente, em qualquer área do conhecimento.

11.2 História

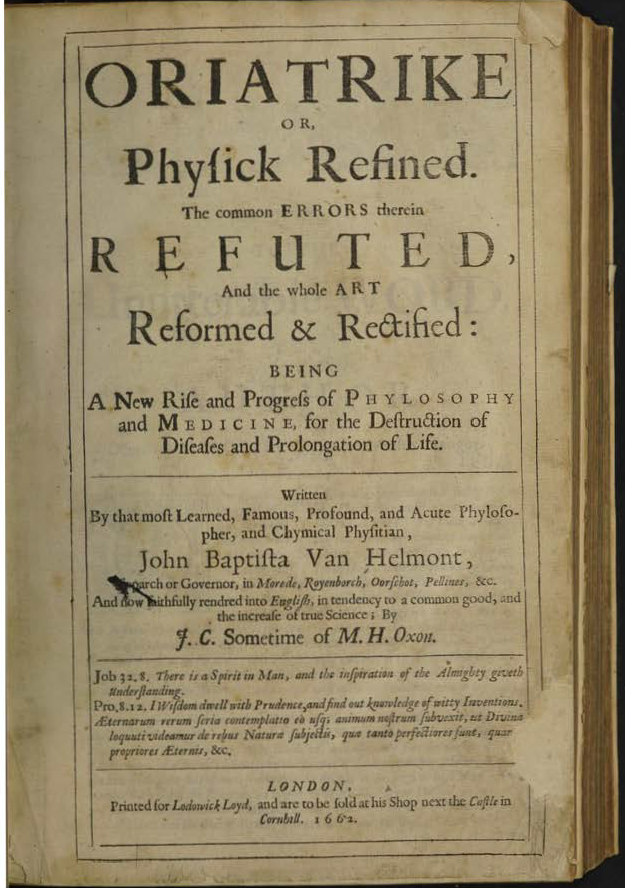

Figure 11.3: Oriatrike or, physick refined. The common errors therein refuted, and the whole art reformed and rectified: being a new rise and progress of phylosophy and medicine, for the destruction of diseases and prolongation of life (p. 526)

Antigas referências relativas a testes de valores remontam aos séculos XVIII e XIX. Historicamente podemos retroceder a 1662, quando o médico flamengo Jean Baptista Van Helmont escreveu um desafio (aposta de 300 florins) em seu livro (Figura 11.4), sobre um procedimento teste que consistiria em se dividir 200 ou 500 pacientes com febre e pleurite em dois grupos iguais e aplicar a eles diferentes tratamentos: os habitualmente adotados pelos médicos da época e os seus próprios métodos. Ao final de um período de tempo (não foi especificado) verificar quantos funerais ocorreriam num e no outro (o livro foi publicado após sua morte, ocorrida em 1944, e não se tem registro sobre sua realização efetiva).

Figure 11.4: Tratamento mais utilizado à época (sangria)

Figure 11.5: John Arbuthnot, FRS (1667-1735)

Outro registro histórico é o artigo publicado em 1710 na Royal Society’s Philosophical Transactions pelo médico escocês John Arbuthnot (1667-1735, Figura 11.5): An argument for Divine Providence (link).

Este artigo foi um marco na história da estatística; em termos modernos, ele realizou testes de hipóteses estatísticas, calculando o p-valor através de um teste de sinais e interpretou-o como estatisticamente significante e assim rejeitou a hipótese nula. Isso é creditado como “[…] o primeiro uso de testes de significância […]” ( in “Estatísticos do século”, David Bellhouse, 2001).

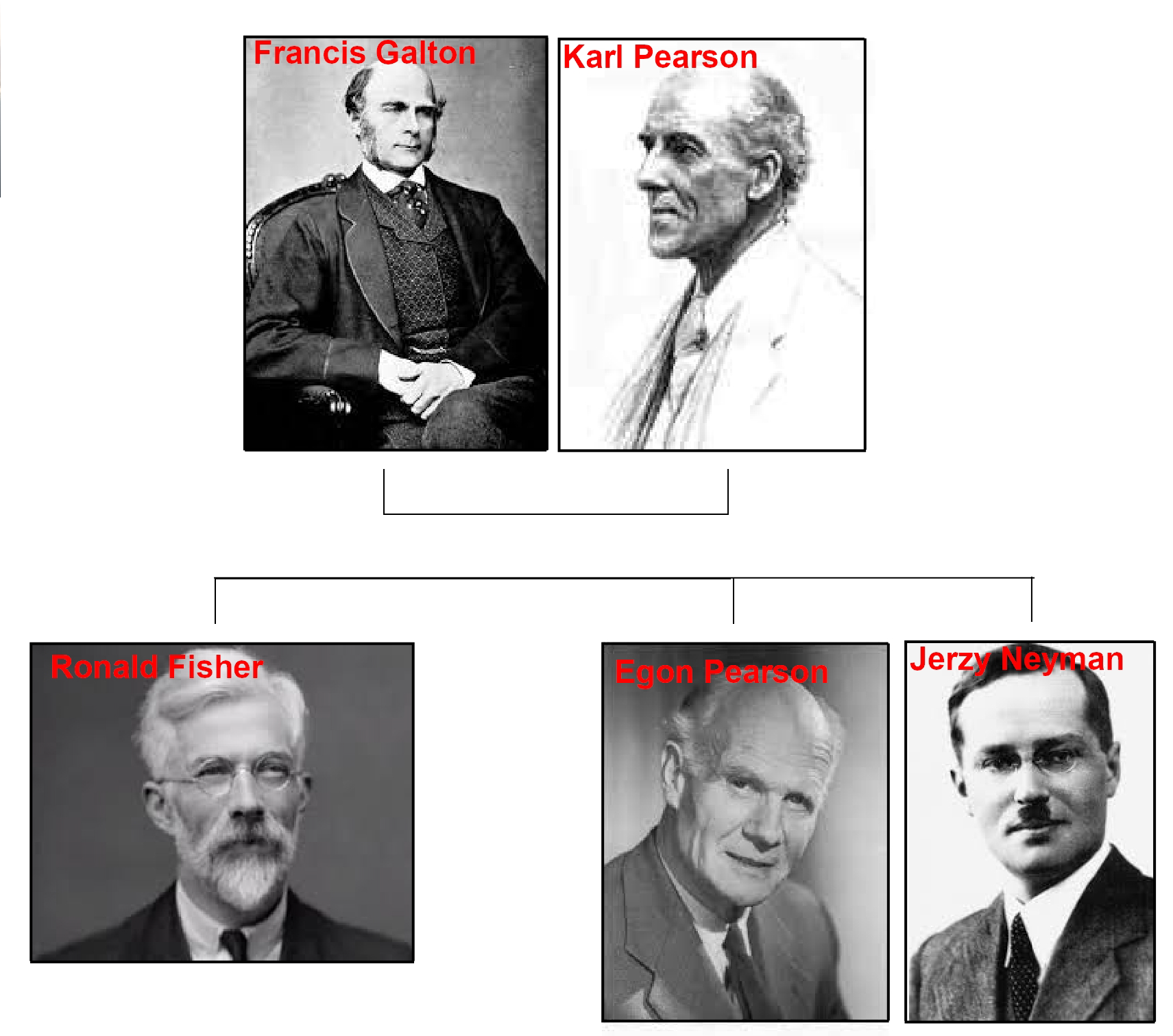

A estruturação dos testes de hipóteses, tal como são promovidos atualmente, é devida à metodológia empreendida por alguns dos mais destacados cientistas da área do final do século XIX e começo do XX (Figura 11.6).

Figure 11.6: Personagens históricos

Em 1932 Karl Pearson se aposentou com professor da University College London e diretor do Laboratório Galton de eugenia. Apesar das objeções de Fisher, o laboratório de estatística foi dividido em dois departamentos. O Departamento de estatística (criado em 1901, o primeiro do gênero em uma universidade), assumido pelo filho mais novo de Karl, Egon; e o Laboratório de eugenia, assumido por seu sucessor na cadeira de Eugenia, Ronald Fisher.

O artigo de Henry F. Inman (Karl Pearson and R. A. Fisher on Statistical Tests: A 1935 Exchange From Nature, 1994) registra uma intensa troca de correspondências entre Fisher e Pearson tendo por assunto suas diferenças conceituais matemáticas e estatísticas, pela contrariedade de Pearson ante a continuidade de Fisher em lecionar teoria estatística e até mesmo por espaço físico para os experimentos científicos de Fisher, ao remover material do Museu de eugenia deixado por Pearson.

O pensamento estatístico da primeira metade do século XXI tem seu interesse voltado à solução dos problemas de testes de hipóteses e sua formulação e filosofia, tal como hoje são conhecidos, foi em grande parte criada por Ronald Aylmer Fisher (1890-1962), Jerzy Neyman (1894-1981) e Egon Sharpe Pearson (1895-1980) no período compreendido entre 1915-1933:

- Estudo biológico realizado por Karl Pearson para tentar associar informações coletadas a distribuições de probabilidade apresentava os componentes básicos de um teste de hipóteses;

- Ronald Fisher (1925): Statistical Methods for Research Workers;

- George Waddel Snedecor (1940): Statistical Methods; e,

- Erich Leo Lehmann (1959): Testing Statistical Hypotheses condensando os estudos desenvolvidos em 1920 pelo filho de Pearson, Egon, e o matemático polonês, Jerzy Neyman (formulação de Neyman-Pearson).

11.3 Conceitos

A metodologia analisada na estruturação do método dos testes de hipóteses no fornece elementos auxiliares da decisão de rejeitar ou não - sob um prisma probabilístico - determinada conjectura postulada acerca de um parâmetro da população estudada.

A conclusão de um teste de hipóteses resume-se a: aceitar ou rejeitar uma hipótese. Muitos estatísticos não adotam a expressão aceitar uma hipótese preferindo, no lugar, usar a expressão não rejeitar a hipótese sob um certo nível de significância.

Por que essa distinção entre aceitar e não rejeitar?

Ao se usar a expressão aceitar pode haver uma pré-concepção de que a hipótese é universalmente verdadeira (lembrando que a conclusão encontra-se alicerçada simplesmente em uma amostra).

Utiliando-se a expressão não rejeitar salienta-se que a informação trazida pelos dados (a amostra) não foi suficientemente robusta para que pudéssemos abandonar essa hipótese em favor de uma outra.

Alguns dizem que os estatísticos não se perguntam qual a probabilidade de estarem certos; mas de não estarem errados.

Um teste de hipóteses guarda uma certa semelhança a um julgamento. Caso não haja indício forte o suficiente que comprove a culpa do acusado ele é declarado como inocente (mesmo que não o seja de fato). No contexto estatístico, os indícios que nos levam a rejeitar uma hipótese provêm da análise de informações observadas na amostra.

A hipótese nula (H0) é a proposição ``tradicional’’ que reflete a situação na qual não há mudança. É, pois, uma hipótese conservadora, resultado de experimentos anteriores.

A hipótese alternativa (H1) contradiz aquilo anunciado pela hipótese nula, é uma hipótese inovadora.

Inicialmente a hipótese nula ela é assumida como verdadeira para, logo a seguir, ser confrontada novas evidências amostrais para se verificar a sustentabilidade de sua afirmação:

- caso a informação amostral demonstre a consistência de hipótese nula tudo o que pode ser feito é se decidir por sua manutenção (falho na tentativa de se derrubar a hipótese conservadora); e,

- caso não seja, analisa-se quão improvável pode ser a informação amostral além de uma dúvida razoável ou mera coincidência (nível de significância).

``Em relação a qualquer experimento não devemos falar desta hipótese como a hipótese nula, e deve-se atentar que a hipótese nula nunca é provada ou estabelecida, mas é, possivelmente, refutada, no decorrer da experimentação. Todo experimento deve existir apenas para das aos fatos a chance de refutar a hipótese nula…’’ (The Design of Experiments, Ronald Aylmer Fisher, 1935, p. 19)

O objetivo de um teste de hipóteses é, pois, o de tomar uma decisão no sentido de verificar se existem razões para rejeitar ou não a hipótese nula. Esta decisão é baseada na informação disponível, obtida a partir de uma amostra, que se recolhe da população.

Teste de hipóteses nos possibilitam associar um nível de significância (\(\alpha\)) como medida probabilística do erro que se pode incorrer ao se concluir pela rejeição de uma hipótese verdadeira, na tomada de decisão.

Nível de significância (\(\alpha\)) é estabelecido pelo pesquisador (baseado tanto na expertise dele, quanto no campo a que o estudo pertence) antes do experimento ser realizado e corresponde ao grau do risco que se deseja incorrer ao se “rejeitar” uma hipótese verdadeira.

Nível de confiança (\(1-\alpha\)) é a medida da confiabilidade de nossa conclusão no teste de hipóteses: “não rejeitar” uma hipótese verdadeira.

11.4 Natureza dos erros

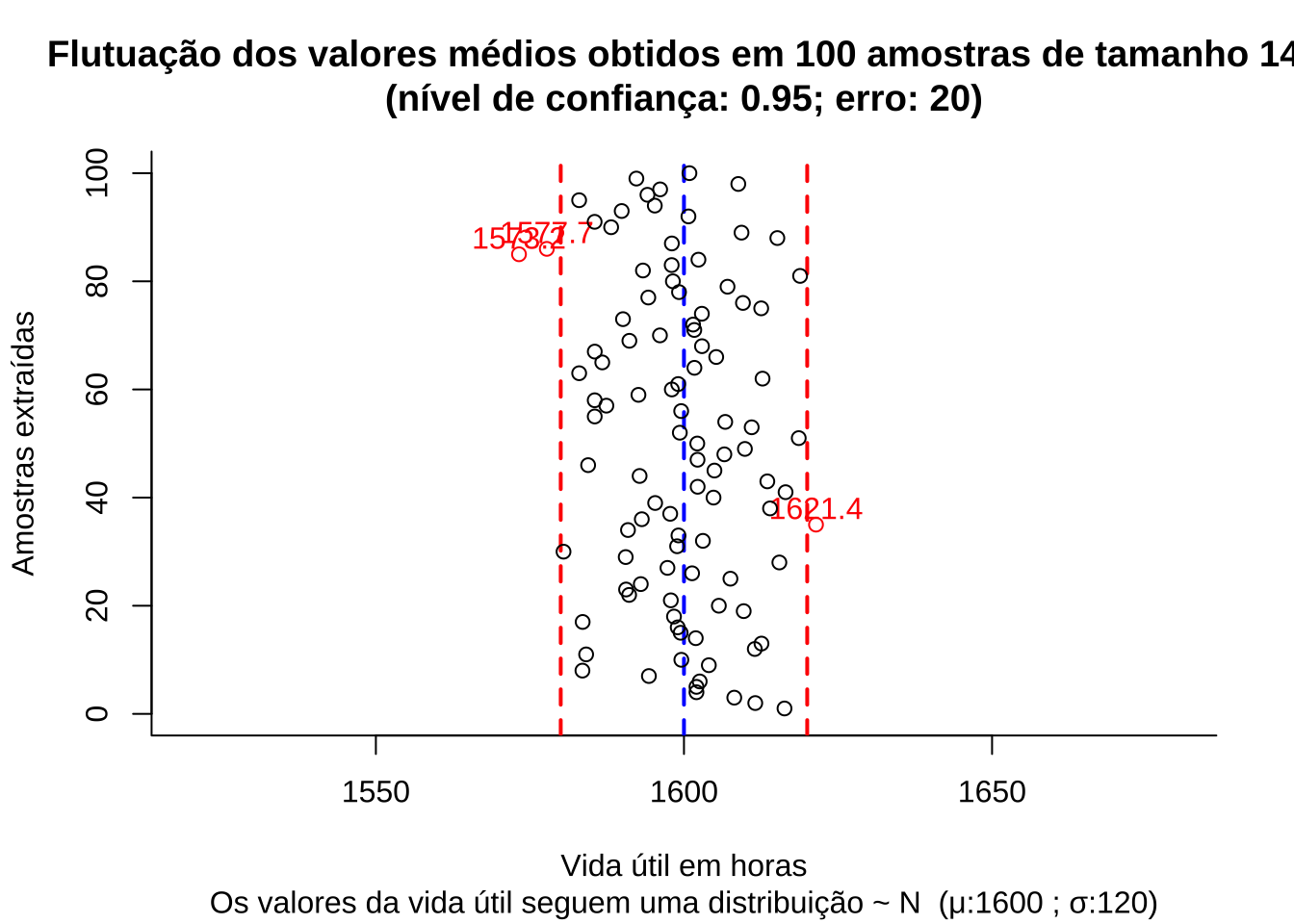

Para introduzir os conceitos relacionados aos erros considere uma situação onde uma empresa produz lâmpadas e a vida útil média, em horas, dessas lâmpadas segue uma distribuição Normal tal que \(VU \sim N (1600, 120)\).

Se não temos conhecimento algum sobre a real vida útil média dessas lâmpadas e alguém nos afirma que a vida útil é de 1.600 h, para confirmar ou não essa proposição (de um modo ``científico’’) devemos extrair uma amostra.

Usando conceitos já explicados em uma unidade anterior podemos determinar o tamanho amostral em função de:

- um erro máximo tolerado: \(\varepsilon\)=20 horas;

- um nível de significância estabelecido: \(\alpha\)=0,05; e,

- e alguma informação sobre a medida da variabilidade da variável em estudo: \(\sigma\)=120 horas (no caso, o desvio padrão populacional).

Figure 11.7: Flutuação dos valores médios para diversas amostras extraídas de uma mesma população distribuição \(\sim N (\mu; \sigma)\)

## mu media erro li ls

## 1 1600 1591 -8.6766 1570 1613

## 2 1600 1618 17.6723 1596 1639

## 3 1600 1599 -0.5731 1578 1621

## 4 1600 1605 4.7897 1586 1623

## 5 1600 1585 -15.4880 1566 1603

## 6 1600 1587 -12.6175 1568 1607

## 7 1600 1615 15.4379 1597 1634

## 8 1600 1605 5.4644 1584 1627

## 9 1600 1617 17.0182 1595 1639

## 10 1600 1599 -1.0790 1579 1619

## 11 1600 1593 -6.7506 1571 1615

## 12 1600 1591 -9.0952 1570 1612

## 13 1600 1592 -8.4440 1571 1612

## 14 1600 1607 6.8580 1587 1627

## 15 1600 1603 3.0582 1584 1622

## 16 1600 1604 4.1727 1583 1626

## 17 1600 1599 -0.7169 1577 1622

## 18 1600 1608 7.8430 1587 1629

## 19 1600 1595 -4.7456 1575 1616

## 20 1600 1600 -0.3628 1581 1618

## 21 1600 1593 -6.6457 1575 1612

## 22 1600 1597 -2.8221 1577 1618

## 23 1600 1589 -10.8907 1570 1609

## 24 1600 1598 -2.2406 1576 1619

## 25 1600 1592 -8.0797 1573 1611

## 26 1600 1596 -4.1539 1577 1614

## 27 1600 1582 -17.6702 1561 1604

## 28 1600 1593 -6.8545 1572 1614

## 29 1600 1592 -8.2887 1574 1609

## 30 1600 1603 2.9773 1583 1623

## 31 1600 1613 12.5894 1594 1631

## 32 1600 1595 -4.5585 1577 1614

## 33 1600 1613 12.7968 1591 1635

## 34 1600 1598 -2.3091 1576 1619

## 35 1600 1619 18.9823 1599 1639

## 36 1600 1595 -5.0581 1574 1616

## 37 1600 1586 -13.7631 1568 1605

## 38 1600 1600 -0.4674 1581 1618

## 39 1600 1596 -4.1615 1576 1616

## 40 1600 1592 -7.6328 1572 1612

## 41 1600 1603 2.9170 1582 1624

## 42 1600 1594 -6.2331 1573 1615

## 43 1600 1610 10.3274 1590 1631

## 44 1600 1593 -7.0484 1573 1613

## 45 1600 1612 11.7343 1592 1632

## 46 1600 1615 15.1498 1594 1636

## 47 1600 1617 17.2001 1598 1637

## 48 1600 1595 -4.6127 1576 1615

## 49 1600 1604 4.1462 1584 1624

## 50 1600 1604 3.9773 1585 1623

## 51 1600 1591 -9.4479 1569 1612

## 52 1600 1613 12.6580 1592 1634

## 53 1600 1594 -6.4174 1573 1614

## 54 1600 1613 13.3751 1593 1634

## 55 1600 1593 -6.8724 1573 1613

## 56 1600 1606 5.6968 1585 1627

## 57 1600 1581 -18.7842 1563 1599

## 58 1600 1596 -3.5253 1577 1616

## 59 1600 1586 -13.9140 1566 1606

## 60 1600 1605 4.9333 1584 1625

## 61 1600 1623 22.8260 1602 1644

## 62 1600 1615 14.9017 1592 1637

## 63 1600 1602 2.2332 1582 1622

## 64 1600 1598 -2.3449 1579 1617

## 65 1600 1609 8.6987 1588 1629

## 66 1600 1594 -5.8648 1575 1613

## 67 1600 1601 0.5536 1581 1620

## 68 1600 1607 6.5919 1586 1628

## 69 1600 1595 -5.0513 1575 1615

## 70 1600 1587 -13.3358 1565 1609

## 71 1600 1608 8.2374 1589 1628

## 72 1600 1572 -27.8383 1552 1592

## 73 1600 1598 -1.5610 1583 1614

## 74 1600 1589 -10.8232 1570 1608

## 75 1600 1576 -23.9697 1558 1594

## 76 1600 1607 6.9723 1586 1628

## 77 1600 1600 -0.1777 1580 1620

## 78 1600 1616 16.1695 1595 1637

## 79 1600 1588 -11.7618 1569 1607

## 80 1600 1594 -5.7939 1575 1613

## 81 1600 1584 -16.4781 1564 1603

## 82 1600 1587 -12.5500 1565 1610

## 83 1600 1587 -13.0960 1568 1606

## 84 1600 1592 -7.6452 1572 1612

## 85 1600 1615 14.6207 1593 1636

## 86 1600 1601 0.5727 1581 1620

## 87 1600 1595 -5.4631 1573 1616

## 88 1600 1579 -21.0096 1559 1599

## 89 1600 1601 1.0990 1581 1621

## 90 1600 1594 -5.8693 1574 1614

## 91 1600 1597 -2.6406 1578 1616

## 92 1600 1595 -5.0709 1576 1614

## 93 1600 1610 9.6771 1587 1632

## 94 1600 1621 20.7002 1600 1641

## 95 1600 1600 0.3443 1581 1620

## 96 1600 1607 6.6060 1586 1627

## 97 1600 1614 13.8683 1596 1632

## 98 1600 1598 -2.4354 1579 1616

## 99 1600 1613 13.4094 1594 1633

## 100 1600 1595 -4.5308 1577 1614

Observa-se que algumas das amostras, numa proporção igual ao nível de significância estabelecido quando do dimensionamento (5%), apresentam médias com valores que se afastam do valor médio populacional mais que o erro estabelecido (20 h).

Como já informado anteriormente, um teste de hipóteses é um método quantitativo e não se baseia, sobremaneira, em impressões pessoais ou outros achismos. Os cenários a seguir foram criados apenas para tentar estabelcer um paralelo entre a probabilidade de se obter médias amostrais muito destoantes da média populacional e uma “inclinação subjetiva” em se rejeitar uma afirmação.

Considere que a sua amostra em particular é uma das que não se afasta tanto do valor que lhe afirmaram (a vida útil das lâmpadas é de 1.600 h).

Nessa situação, talvez você não se “convencesse” de que a vida útil média fosse diferente daquilo que lhe informaram e, assim, não iria recusar a afirmação.

Agora considere que a sua amostra em particular é uma das que se afasta muito do valor que lhe afirmaram.

Nessa nova situação, certamente você iria “suspeitar” que a vida útil média é diferente daquilo que lhe informaram e assim, recusar a afirmação.

Na primeira decisão, você não recusou uma afirmação que era, de fato, verdadeira; ao passo que na segunda, você rejeitou uma afirmação que era verdadeira (lembrando que você não sabia que a vida útil média é, de fato, 1.600 h).

Como se vê no quadro abaixo, há dois tipos de erros envolvidos em um teste de hipóteses e suas consequências, muitas vezes, são bem diferentes.

- Erro do tipo I e

- Erro do tipo II.

Um erro do tipo I ocorre quando o pesquisador rejeita uma hipótese nula quando é verdadeira. A probabilidade (limitada pelo pesquisador) de se incorrer em um erro do tipo I é chamada de nível de significância e é frequentemente denotada pela letra grega \(\alpha\).

Um erro do tipo II ocorre quando o pesquisador não rejeita uma hipótese nula que é falsa. A probabilidade de cometer um erro do tipo II, também chamada de poder do teste e é frequentemente denotada pela letra grega \(\beta\).

| Valor real do parâmetro | Não rejeitar | Rejeitar |

| (desconhecido) | H0 | H0 |

| H0 verdadeira | Decisão correta | Erro do tipo I |

| probabilidade associada=(1 − α) | probabilidade associada= α | |

| H0 falsa | Erro do tipo II | Decisão correta |

| probabilidade associada=β | probabilidade associada =(1 − β) |

No quadro acima identificam-se:

- \(\alpha\): a probabilidade associada ao cometimento de um erro do tipo I: rejeitar a hipótese nula sendo ela verdadeira (arbitrado pelo pesquisador, é denominado nível de significância do teste);

- \(\beta\): a probabilidade associada ao cometimento de um erro do tipo II: não rejeitar a hipótese nula sendo esta falsa;

- (1-\(\alpha\)): o nível de confiança estabelecido para a decisão, a probabilidade associada em não se rejeitar a hipótese nula (\(H_{0}\)) quando ela é, de fato, verdadeira; e,

- (1-\(\beta\)): o poder do teste, a probabilidade associada em não se aceitar a hipótese nula (\(H_{0}\)) quando ela é, de fato, falsa.

Qual erro é o pior?

Por exemplo, se alguém testa a presença de alguma doença em um paciente, decidindo incorretamente sobre a necessidade do tratamento (ou seja, decidindo que a pessoa está doente), pode submetê-lo ao desconforto pelo tratamento (efeitos colaterais) além de perda financeira pela despesa incorrida.

Mas por outro lado, a falha em diagnosticar a presença da doença no paciente pode levá-lo à morte pela ausência de tratamento.

Outro exemplo clássico a ser citado seria o de condenar uma pessoa inocente ou libertar um criminoso.

Como não há uma regra clara sobre qual tipo de erro é o pior recomenda-se quando se usa dados para testar uma hipótese observar com muito cuidado as consequências que podem seguir os dois tipos de erros. Vários especialistas sugerem o uso de uma tabela como a abaixo para detalhar as consequências de um erro Tipo 1 e Tipo 2 em sua análise específica.

| H0 explicada | Erro tipo 1: rejeitar H0 quando verdadeira | Erro tipo II: não rejeitar H0 quando falsa |

|---|---|---|

| O medicamento “A“ não alivia a Condição “B“ | O medicamento “A“ não alivia a Condição “B“, mas não é eliminado como opção de tratamento | O medicamento “A“ alivia a condição “B“, mas é eliminado como opção de tratamento |

| Consequências | Pacientes com Condição “B“ que recebem o Medicamento “A“ não obtêm alívio. Eles podem experimentar piora da condição e/ou efeitos colaterais, até e incluindo a morte. A empresa produtora do medicamento pode enfrentar processos judiciais | Um tratamento viável permanece indisponível para pacientes com Condição “B“. Os custos de desenvolvimento são perdidos. O potencial lucro pela produção do medicamente “A“ pela empresa é eliminado. |

É desejável conduzir o teste de um modo a manter a probabilidade de ambos os tipos de erro em um mínimo.

- aumentar o tamanho amostral reduz a probabilidade associada ao cometimento de erro do tipo II (\(\beta\)) e, consequentemente, aumenta o poder do teste (\(1- \beta\));

- aumentar o nível de significância (\(\alpha\)) tem implicação direta na probabilidade associada ao cometimento de erro do tipo I todavia reduz a probabilidade associada ao cometimento de erro do tipo II (\(\beta\)).

11.5 Recomendações gerais

- o pesquisador deve delimitar o objeto de sua pesquisa;

- uma boa hipótese deve ser baseada em uma boa pergunta sobre o objeto do estudo;

- deve ser simples e específica;

- deve ser formulada na fase propositiva da pesquisa e não após a coleta de dados (post hoc);

- enunciar as hipóteses: as hipóteses são apresentadas de tal maneira que sejam mutuamente exclusivas (o que afirmado por uma deve ser contradito pela outra);

- as hipóteses são comumente denominadas por hipótese nula (\(H_{0}\)) e hipótese alternativa (\(H_{1}\));

- a hipótese nula (\(H_{0}\)) que será testada sob um nível de significância (\(\alpha\)) é, em geral, de concordância com o parâmetro que se estuda da população (conservadora) e baseada em conhecimento prévio;

- a hipótese alternativa (\(H_{1}\)) é contrária, oposta, antagônica à hipótese nula (novadora); e,

- estabelecer um nível apropriado para a significância \(\alpha\) (em alguns campos do conhecimento níveis de significância muito reduzidos são impraticáveis).

11.6 Efeito do limite central

Seja \(X_{1}, X_{2}, ...\) uma sequência de variáveis aleatórias independentes e identicamente distribuídas, cada uma com média finita \(\mu=E(X_{i})\).

A Lei forte dos grandes números (teorema) demonstra que

\[

\frac{X_{1} + X_{2} + \dots, X_{n}}{n} \to \mu

\]

quando \(n \to \infty\).

Isto é, \(P\{lim_{\to \infty}(\frac{X_{1} + X_{2} \dots + X_{n}}{n})=\mu\}=1\)

11.6.1 Erro global

O erro global (\(\varepsilon= X -\mu\)) é um agregado de componentes.

Uma medida (observação) obtida em um ensaio experimental específico pode estar sujeita a erros:

- analíticos;

- de amostragem (física, química, biológica, …);

- processuais (produzido por falhas no cumprimento das configurações exatas das condições experimentais);

- erros devidos à variação de matérias-primas;

- medição (diferentes operadores de equipamentos ou equipamentos descalibrados).

Assim, \(\varepsilon\) será uma função linear de componentes \(\varepsilon_{1}\), \(\varepsilon_{2}, ...,\varepsilon_{n}\) de erros. Se cada erro individual for relativamente pequeno, será possível aproximar o erro global como uma função linear dos componentes de erros, onde \(a\) são constantes:

\[ \varepsilon = a_{1}\varepsilon_{1} + a_{2}\varepsilon_{2} + ... + a_{n}\varepsilon_{n} \]

O Teorema do limite central afirma que, sob condições quase sempre satisfeitas no mundo real da experimentação, a distribuição de tal função linear de erros tenderá à uma distribuição Normal quando o número de seus componentes torna-se grande, independentemente da distribuição original da população de onde suas amostras geradoras se originaram.

Seja \(X_{1},\dots,X_{n}\) uma sequência de variáveis aleatórias independentes e identicamente distribuídas, com média \(\mu\) e variância \(\sigma^{2}\).

A distribuição assumirá um perfil

\[ \frac{X_{1} + X_{2} \dots + X_{n} - n \mu}{\sigma \sqrt{n}} \sim \mathcal{N}(0,1) \]

quando \(n \to \infty\).

Assim, para \(-\infty < a < \infty\),

\[ P \{ \frac{X_{1} + X_{2} \dots + X_{n} - n \mu}{\sigma \sqrt{n}} \leq a\}\to \mathcal{N}(0,1) \]

quando \(n \to \infty\).

Denotando-se de um modo alternativo, podemos então definir a estatística Z e sua correspondente distribuição como

\[ Z = \frac{ \stackrel{-}{X} - \mu }{ \frac{\sigma}{\sqrt{n}} } = \frac{\sqrt{n}\left(\stackrel{-}{X}-\mu \right)}{\sigma } \sim \mathcal{N}(0,1) \]

Ou seja, \(Z\) é uma variável aleatória que segue a distribuição Normal com média zero e desvio-padrão unitário (Normal padronizada).

Em resumo: quando, como é habitual, um erro experimental é um agregado de vários erros de componentes, sua distribuição tende para a forma Normal, mesmo a distribuição dos componentes pode ser marcadamente não Normal;

A média da amostra tende a ser distribuída Normalmente, mesmo que as observações individuais em que se baseia não o sejam. Consequentemente, métodos estatísticos que dependam, não diretamente da distribuição das observações individuais, mas na distribuição das médias tendem a ser insensíveis ou robustos à não normalidade.

Procedimentos que comparam médias são geralmente robustos à não normalidade.

11.7 Estruturas das hipóteses

11.7.1 Interpretação gráfica dos níveis de significância/confiança

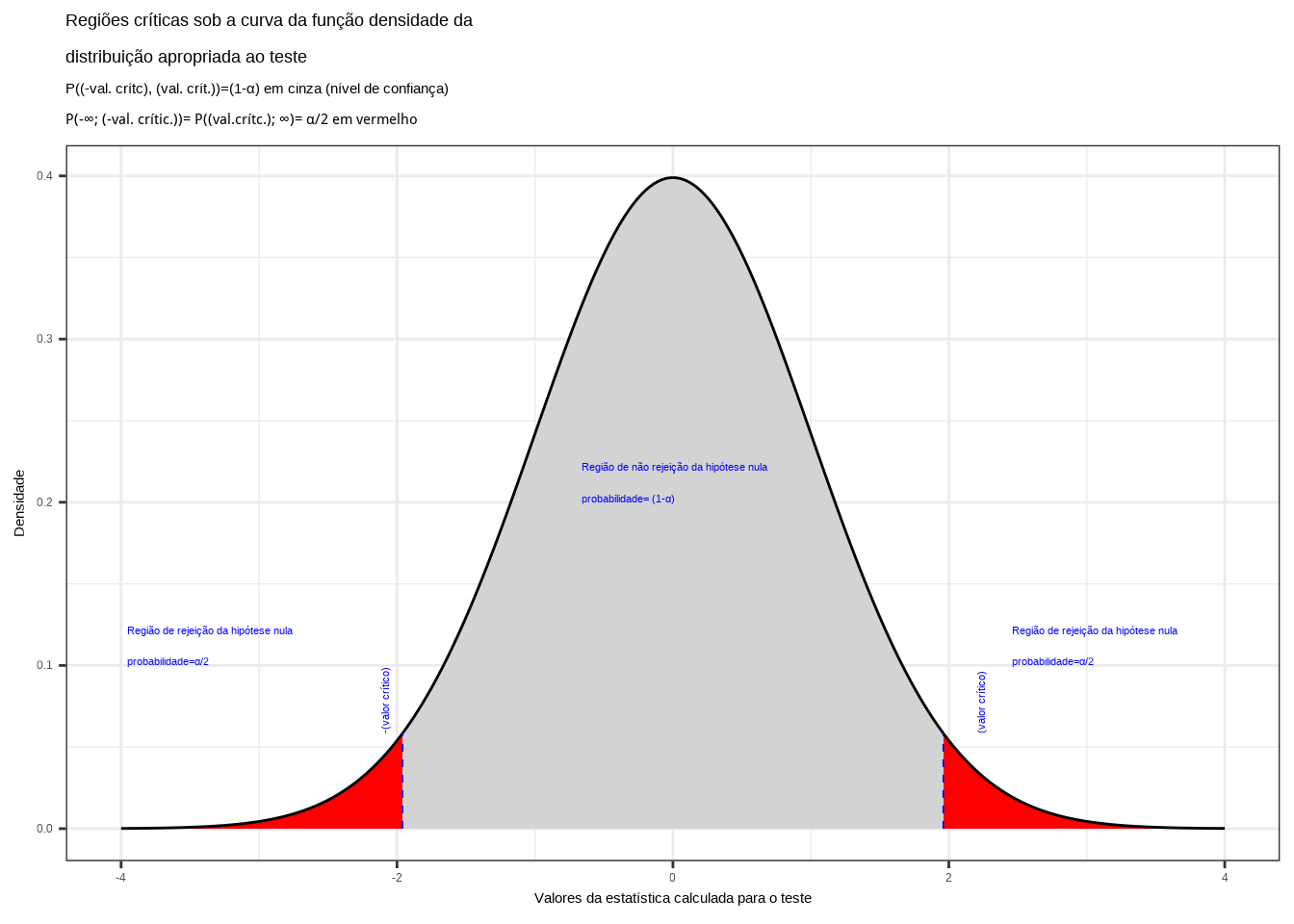

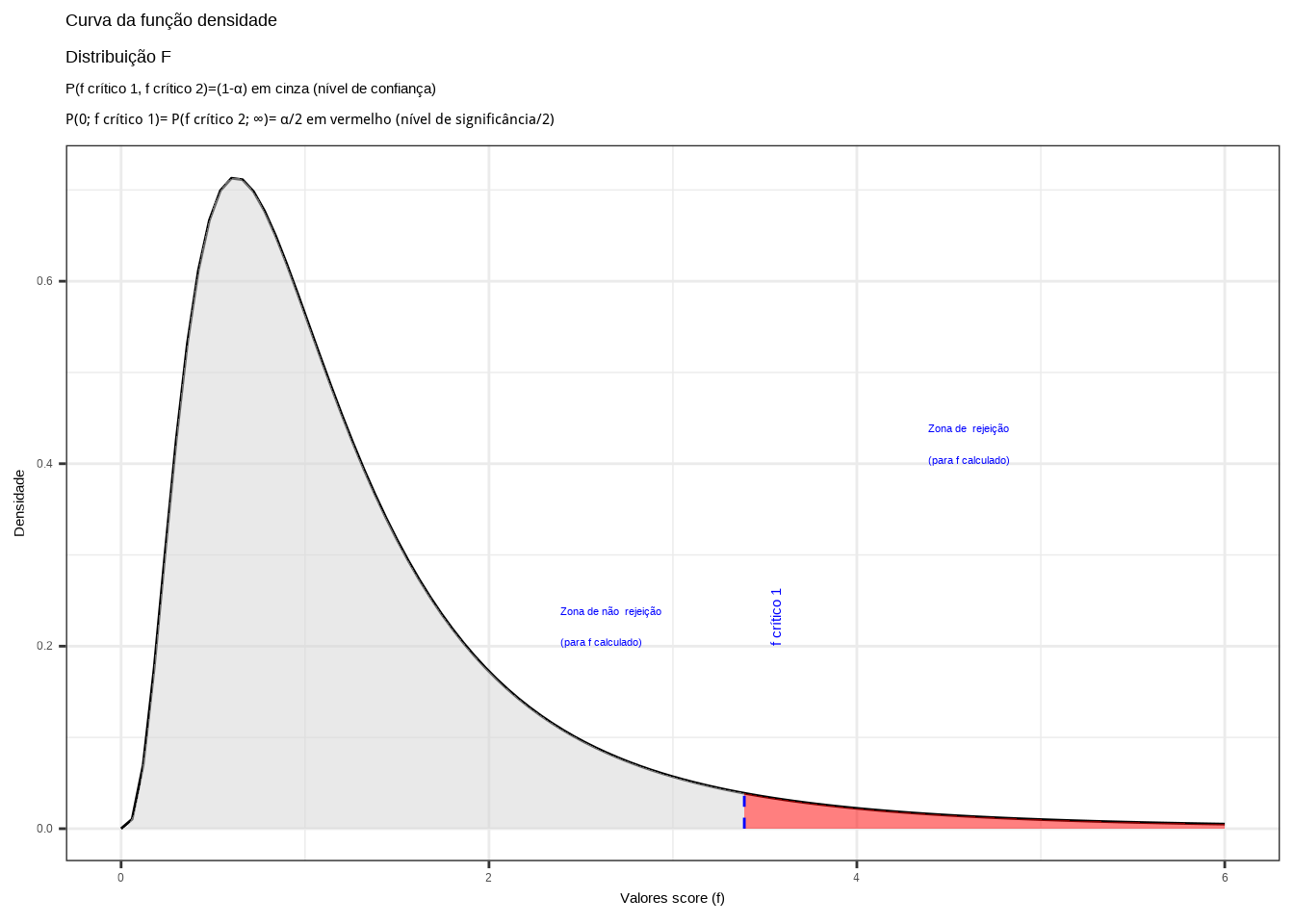

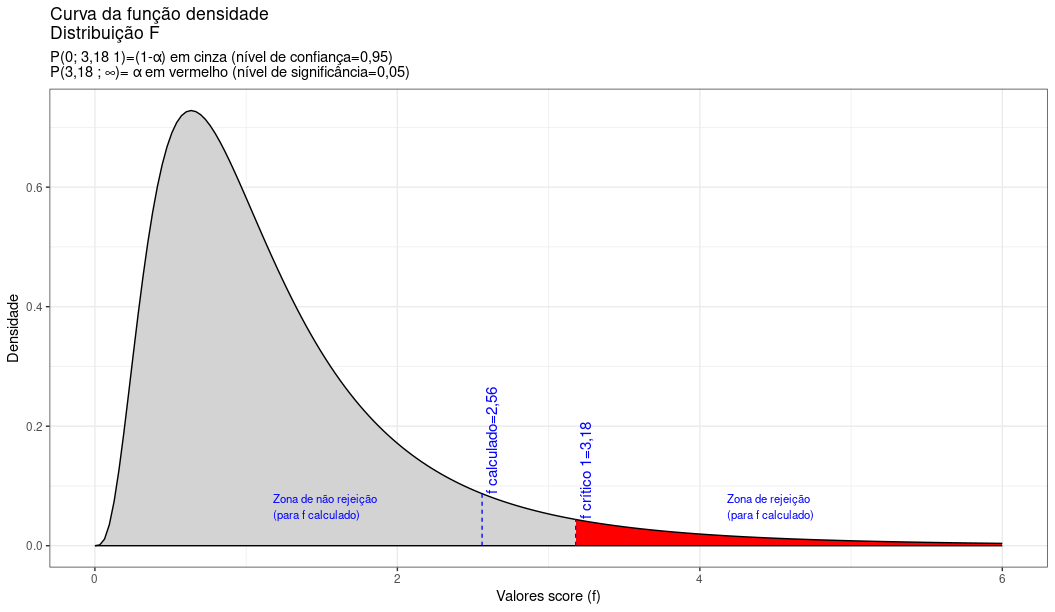

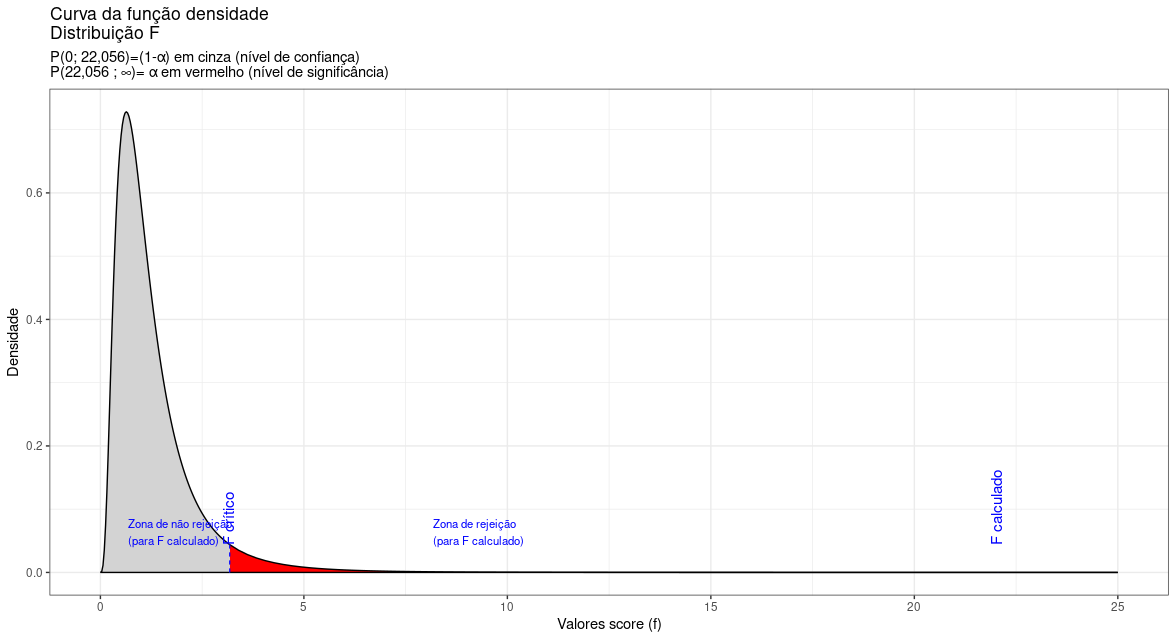

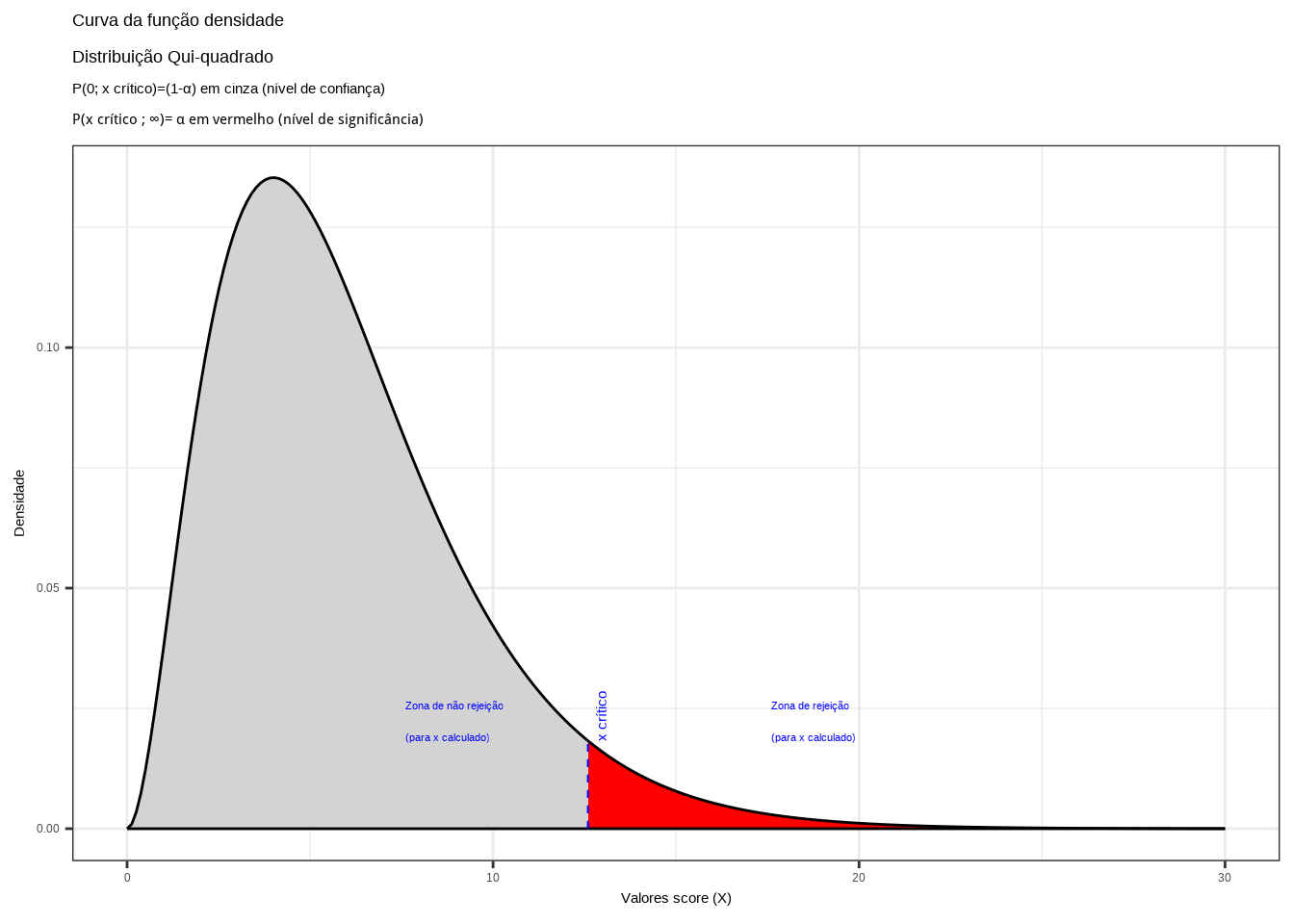

O delineamento de um teste de hipóteses inclui regras de decisão para se rejeitar ou não a hipótese nula.

Essas regras de decisão passam pela comparação dos valores calculados de uma estatística apropriada para o teste em curso com seus valores extremos, frequentemente obtidos em tabelas, os quais estão associados ao complemento de uma probabilidade (o nível de confiança) de ocorrência condizente ao nível de significância estabelecido na pesquisa.

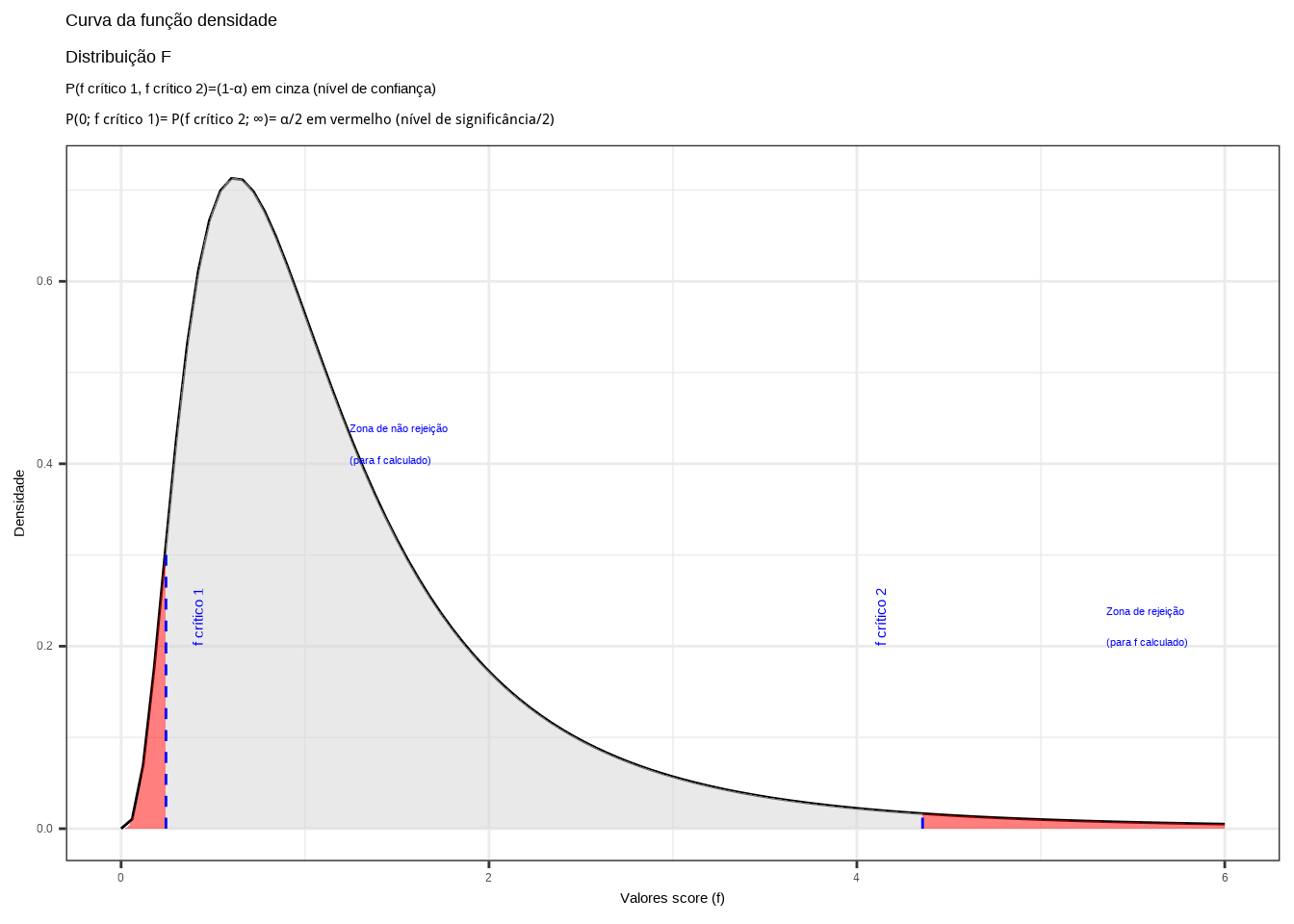

Essa comparação é por demais facilitada se visualizada no gráfico da densidade de probabilidade da distribuição da estatística do teste, onde regiões (baseadas no nível de significância estabelecido) podem ser estabelecidas:

- testes bilaterais ( hipótese alternativa do tipo: diferente de ): a região é fechada, delimitada à esquerda e à direita por valores críticos de estatística do teste;

- testes unilaterais à direita ( hipótese alternativa do tipo: maior que ): a região é fecfada à esquerda, delimitada por um valor crítico da estatística do teste e aberta à direita (ao \(\rightarrow \infty\)[; e,

- testes unilaterais à esquerda ( hipótese alternativa do tipo: menor que ): a região é fechada à direita, delimitada por um valor crítico da estatística do teste e aberta à esquerda ]$ -$).

No gráfico de densidade de probabilidade da estatística do teste temos uma primeira região frequentemente denominada de região de não rejeição: um intervalo de valores dentro do qual, se o valor calculado para a estatística de teste estiver contido, a hipótese nula não será rejeitada.

O intervalo de valores que delimitam a região de não rejeição é tal que a probabilidade dessa região é igual ao nível de confiança \((1-\alpha)\).

Se a estatística calculada para o teste estiver fora da faixa de valores delimitada na região de não rejeição a hipótese nula poderá ser rejeitada sob o nível de significância \(\alpha\) estabelecido; ou seja, a probabilidade de se incorrer em um erro Tipo I: rejeitar a hipótese nula quando ela é verdadeira é igual a \(\alpha\).

Com a popularização dos programas estatísticos computacionais, a probabilidade exata associada ao valor calculado da estatística do teste passou ser neles apresentada de modo default, nominada pela expressão valor p ( p-Value ) que expressa uma probabilidade.

Para melhor entender o valor-p ( p-value) suponha que o valor da estatística do teste seja igual a \(\zeta\). O valor p é o quantil associado (a probabiliadde exata) a \(\zeta\) na distribuição de probabilidade usada como referência. Se o valor p for menor que o nível de significância (\(\alpha\)) estipulado pelo pesquisador, rejeita-se a hipótese nula sob esse nível de significância de cometimento de um erro do tipo I.

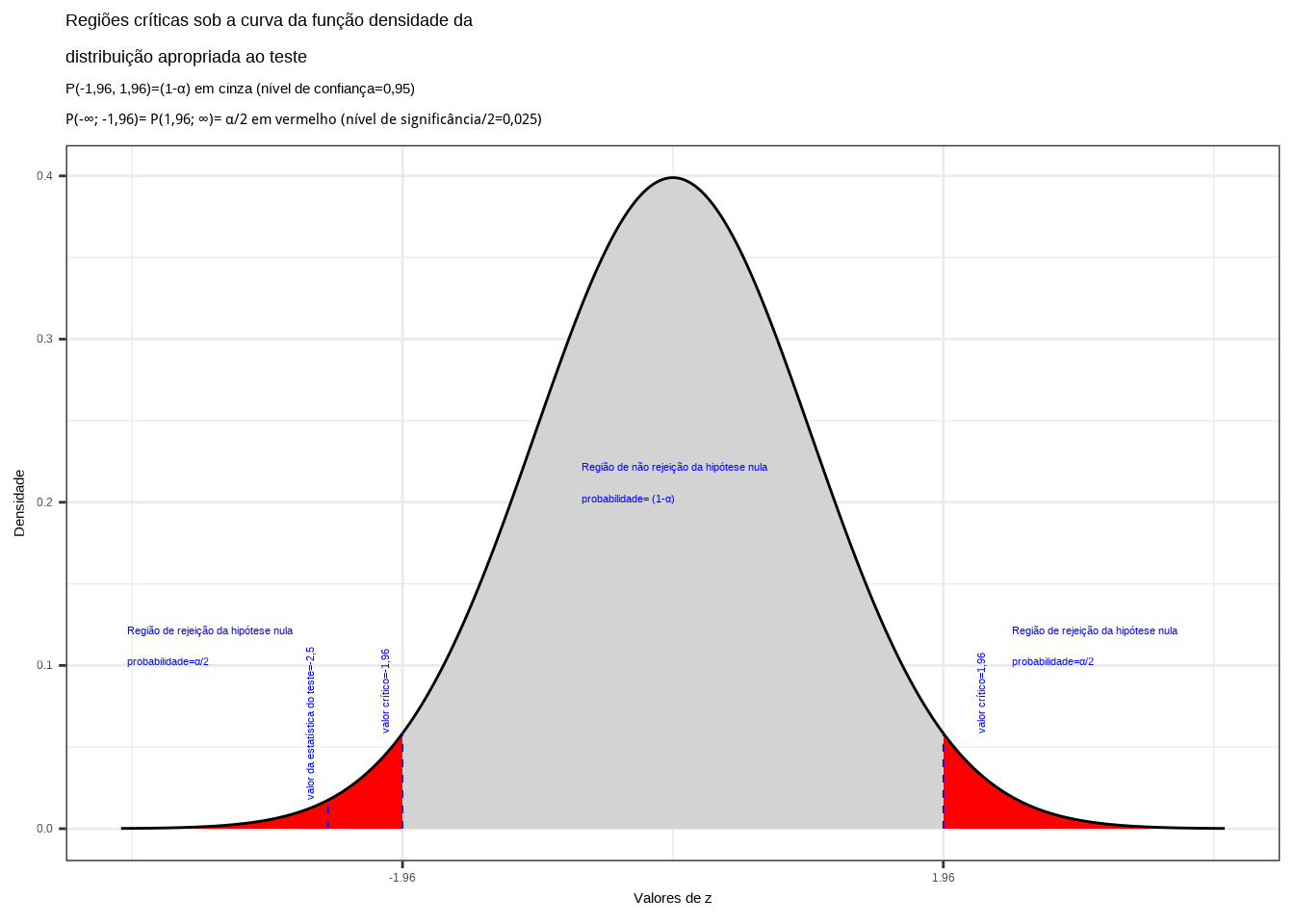

11.7.2 Teste de hipóteses Bilateral

Nesse tipo de teste a hipótese aternativa é proposta como a dizer que o valor em teste é diferente daquele afirmado pela hipótese nula (conservadora):

\[

\begin{cases}

H_{0}: \mu = \mu_{0}\\

H_{1}: \mu \ne \mu_{0}\\

\end{cases}

\]

em que \(\mu_{0}\) é um valor conservador do parâmetro \(\mu\) que se deseja testar.

alfa=0.05

prob_desejada1=alfa/2

z_desejado1=round(qnorm(prob_desejada1),4)

d_desejada1=dnorm(z_desejado1, 0, 1)

prob_desejada2=1-alfa/2

z_desejado2=round(qnorm(prob_desejada2),4)

d_desejada2=dnorm(z_desejado2, 0, 1)

ggplot(NULL, aes(c(-4,4))) +

geom_area(stat = "function",

fun = dnorm,

fill = "red",

xlim = c(-4, z_desejado1),

colour="black") +

geom_area(stat = "function",

fun = dnorm,

fill = "lightgrey",

xlim = c(z_desejado1,0),

colour="black") +

geom_area(stat = "function",

fun = dnorm,

fill = "lightgrey",

xlim = c(0, z_desejado2),

colour="black") +

geom_area(stat = "function",

fun = dnorm,

fill = "red",

xlim = c(z_desejado2,4),

colour="black") +

scale_y_continuous(name="Densidade") +

scale_x_continuous(name="Valores da estatística calculada para o teste") +

labs(title=

"Regiões críticas sob a curva da função densidade da \ndistribuição apropriada ao teste",

subtitle = "P((-val. crítc), (val. crít.))=(1-\u03b1) em cinza (nível de confiança) \nP(-\U221e; (-val. crític.))= P((val.crítc.); \U221e)= \u03b1/2 em vermelho ")+

geom_segment(aes(x = z_desejado1, y = 0, xend = z_desejado1, yend = d_desejada1), color="blue", lty=2, lwd=0.3)+

geom_segment(aes(x = z_desejado2, y = 0, xend = z_desejado2, yend = d_desejada2), color="blue", lty=2, lwd=0.3)+

annotate(geom="text", x=z_desejado1-0.1, y=d_desejada1, label="-(valor crítico)", angle=90, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=z_desejado2+0.3, y=d_desejada2, label="(valor crítico)", angle=90, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=z_desejado1-2, y=0.1, label="Região de rejeição da hipótese nula \nprobabilidade=\u03b1/2", angle=0, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=z_desejado2+0.5, y=0.1, label="Região de rejeição da hipótese nula \nprobabilidade=\u03b1/2", angle=0, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=z_desejado1+1.3, y=0.2, label="Região de não rejeição da hipótese nula \nprobabilidade= (1-\u03b1)", angle=0, vjust=0, hjust=0, color="blue",size=3)+

theme_bw()

Figure 11.8: Regiões críticas, aquém e além das quais, a probabilidade associada aos valores amostrais observados é inferior a \(\frac{\alpha}{2}\), estabelecendo assim um intervalo com nível de confiança igual a \((1-\alpha)\)

Na Figura 11.8 observa-se:

- as regiões de rejeição da hipótese nula (subdivididas nos dois lados) sob a curva da função densidade de probabilidade da distribuição adequada ao teste com probabilidades iguais ao nível de significância \(\alpha\) ;

- a região de não rejeição da hipótese nula (delimitada à esquerda e à direita) com probabilidade igual ao nível de confiança \((1-\alpha)\); e,

- os valores críticos da estatística do teste.

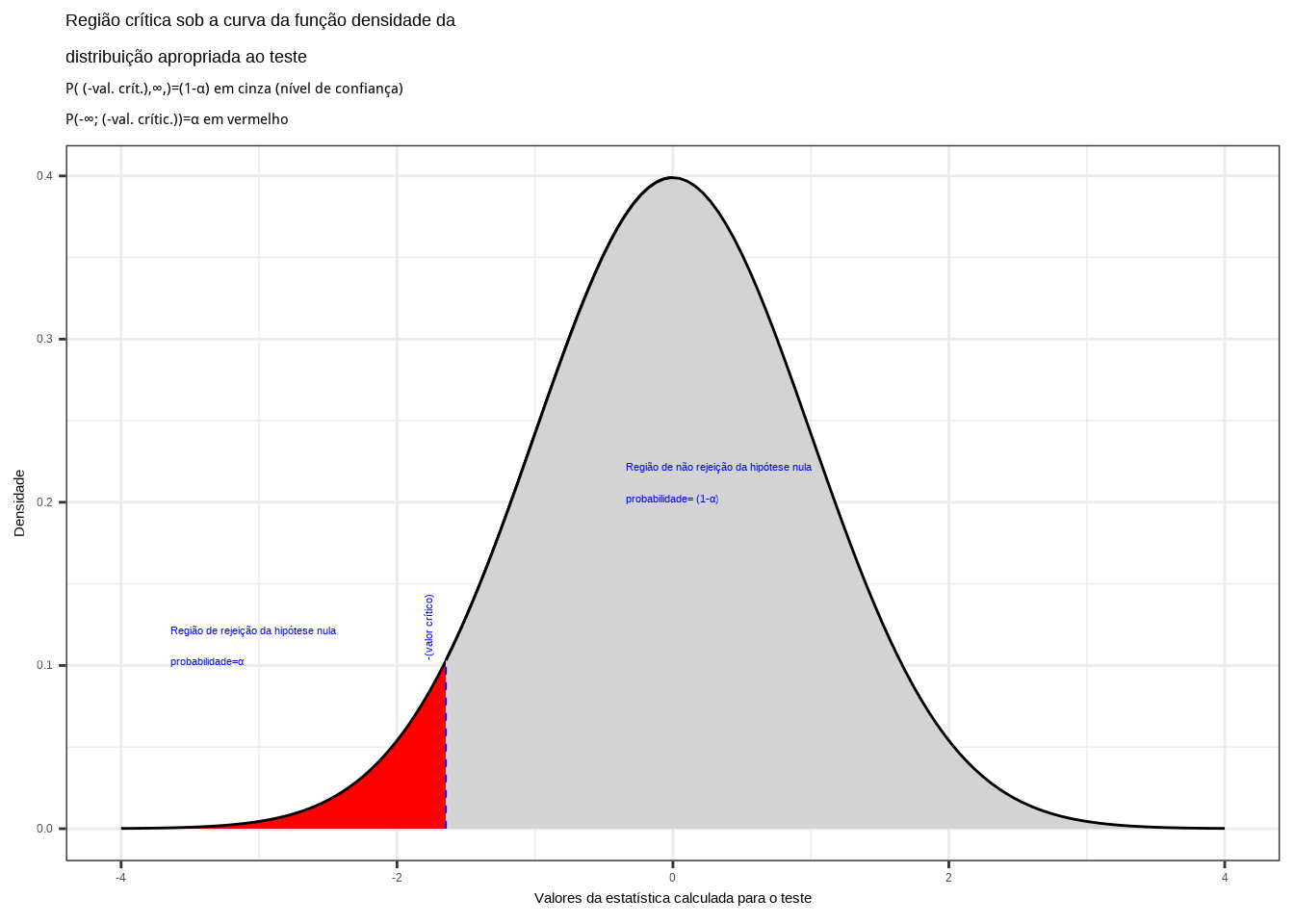

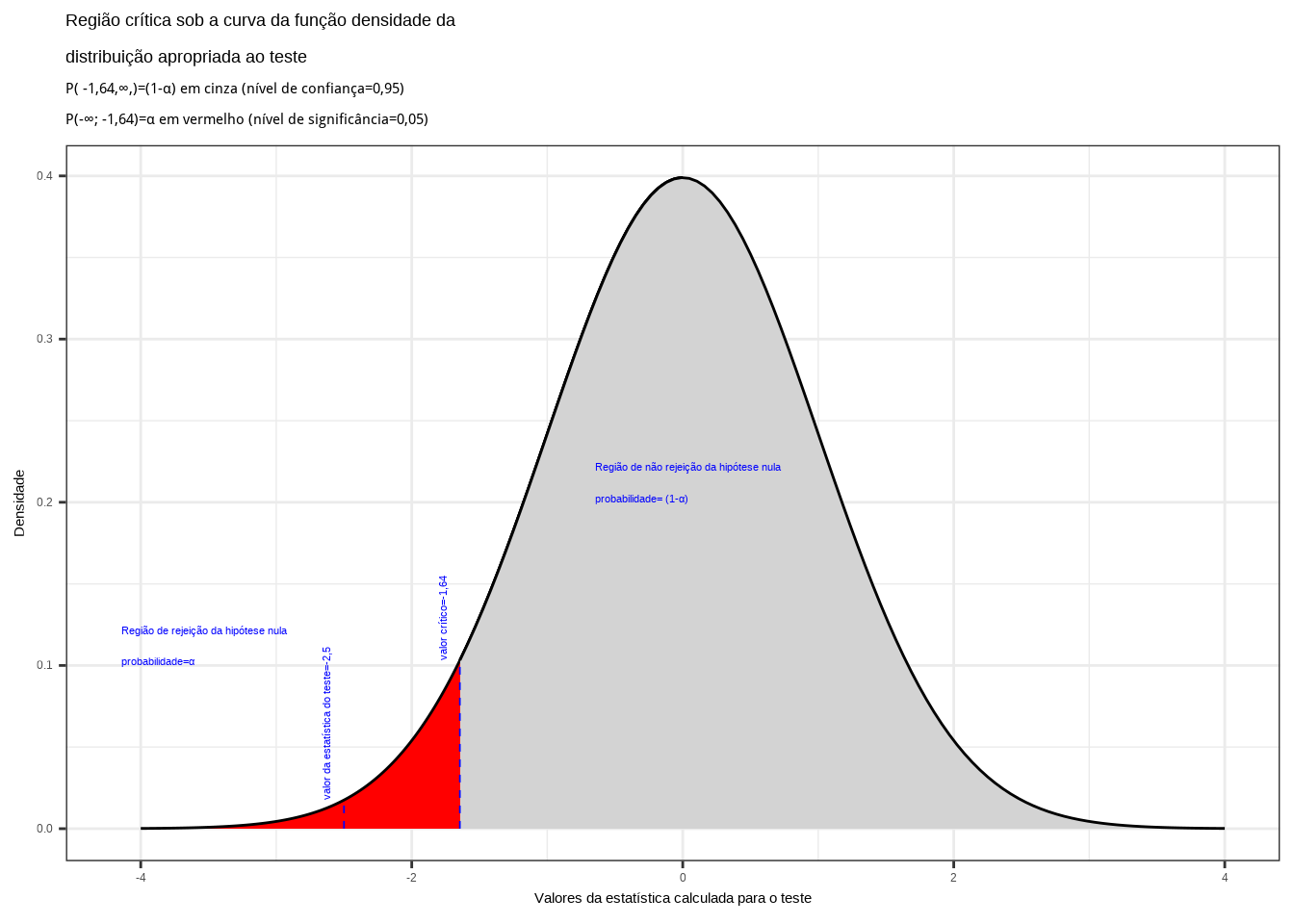

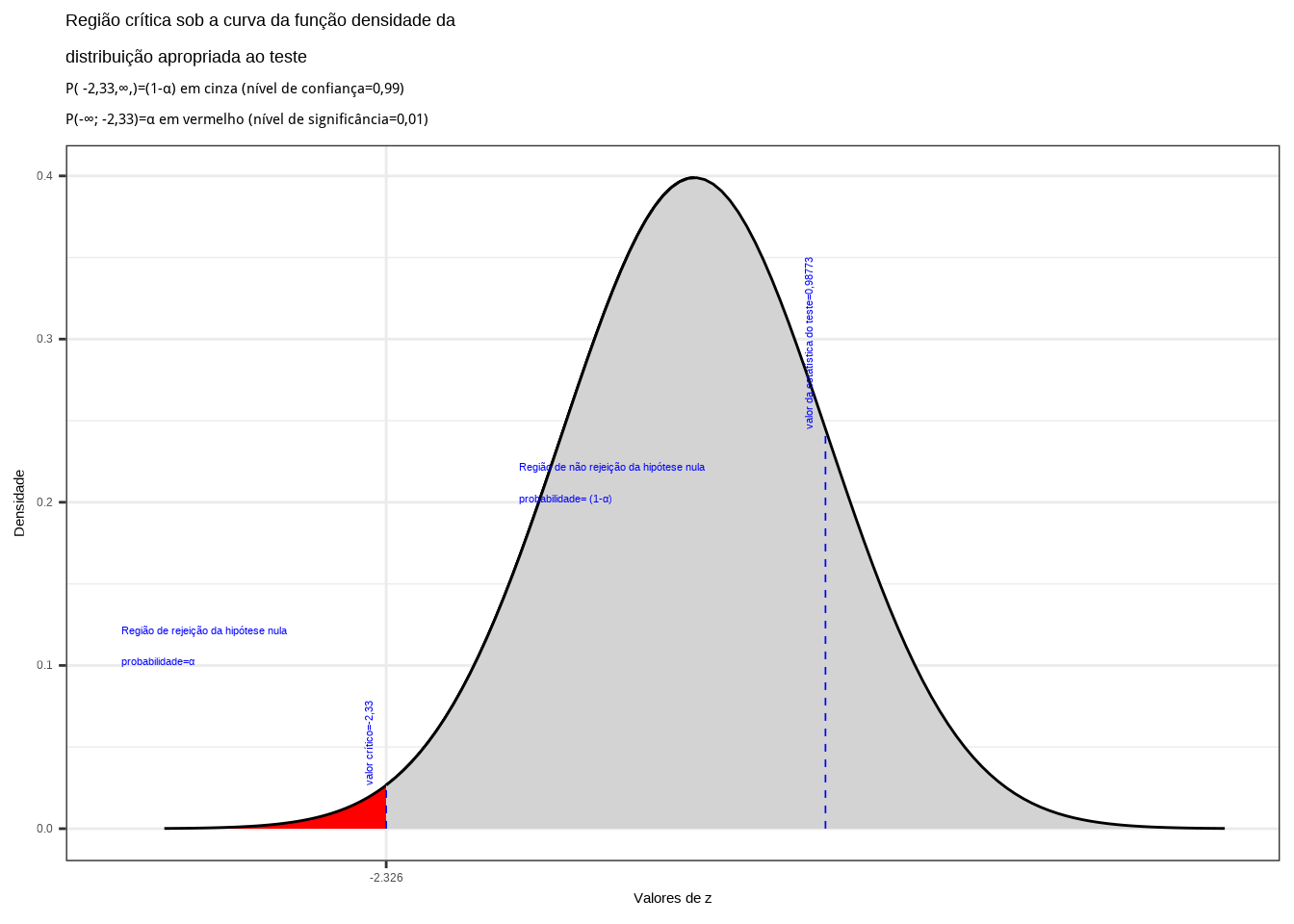

11.7.3 Teste de hipóteses Unilateral à esquerda

Nesse tipo de teste a hipótese aternativa é proposta como a dizer que o valor em teste não apenas é diferente, mas é menor do que aquele afirmado pela hipótese nula (conservadora):

\[ \begin{cases} H_{0}: \mu \ge \mu_{0}\\ H_{1}: \mu < \mu_{0}\\ \end{cases} \]

em que \(\mu_{0}\) é um valor conservador do parâmetro \(\mu\) que se deseja.

alfa=0.05

prob_desejada=alfa

z_desejado=round(qnorm(prob_desejada),4)

d_desejada=dnorm(z_desejado, 0, 1)

ggplot(NULL, aes(c(-4,4))) +

geom_area(stat = "function",

fun = dnorm,

fill = "red",

xlim = c(-4, z_desejado),

colour="black") +

geom_area(stat = "function",

fun = dnorm,

fill = "lightgrey",

xlim = c(z_desejado,0),

colour="black") +

geom_area(stat = "function",

fun = dnorm,

fill = "lightgrey",

xlim = c(0, z_desejado),

colour="black") +

geom_area(stat = "function",

fun = dnorm,

fill = "lightgrey",

xlim = c(z_desejado,4),

colour="black") +

scale_y_continuous(name="Densidade") +

scale_x_continuous(name="Valores da estatística calculada para o teste") +

labs(title=

"Região crítica sob a curva da função densidade da \ndistribuição apropriada ao teste",

subtitle = "P( (-val. crít.),\U221e,)=(1-\u03b1) em cinza (nível de confiança) \nP(-\U221e; (-val. crític.))=\u03b1 em vermelho ")+

geom_segment(aes(x = z_desejado, y = 0, xend = z_desejado, yend = d_desejada), color="blue", lty=2, lwd=0.3)+

annotate(geom="text", x=z_desejado-0.1, y=d_desejada, label="-(valor crítico)", angle=90, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=z_desejado-2, y=0.1, label="Região de rejeição da hipótese nula \nprobabilidade=\u03b1", angle=0, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=z_desejado+1.3, y=0.2, label="Região de não rejeição da hipótese nula \nprobabilidade= (1-\u03b1)", angle=0, vjust=0, hjust=0, color="blue",size=3)+

theme_bw()

Figure 11.9: Região crítica aquém da qual a probabilidade associada aos valores amostrais observados é inferior a \(\alpha\), estabelecendo assim um intervalo com nível de confiança igual a \((1-\alpha)\)

Na Figura 11.9 observa-se:

- a região de rejeição da hipótese nula delimitada sob a curva da função densidade de probabilidade da distribuição adequada ao teste com probabilidade igual ao nível de significância \(\alpha\) ;

- a região de não rejeição da hipótese nula (delimitada à esquerda) com probabilidade igual ao nível de confiança \((1-\alpha)\); e,

- os valores críticos da estatística do teste.

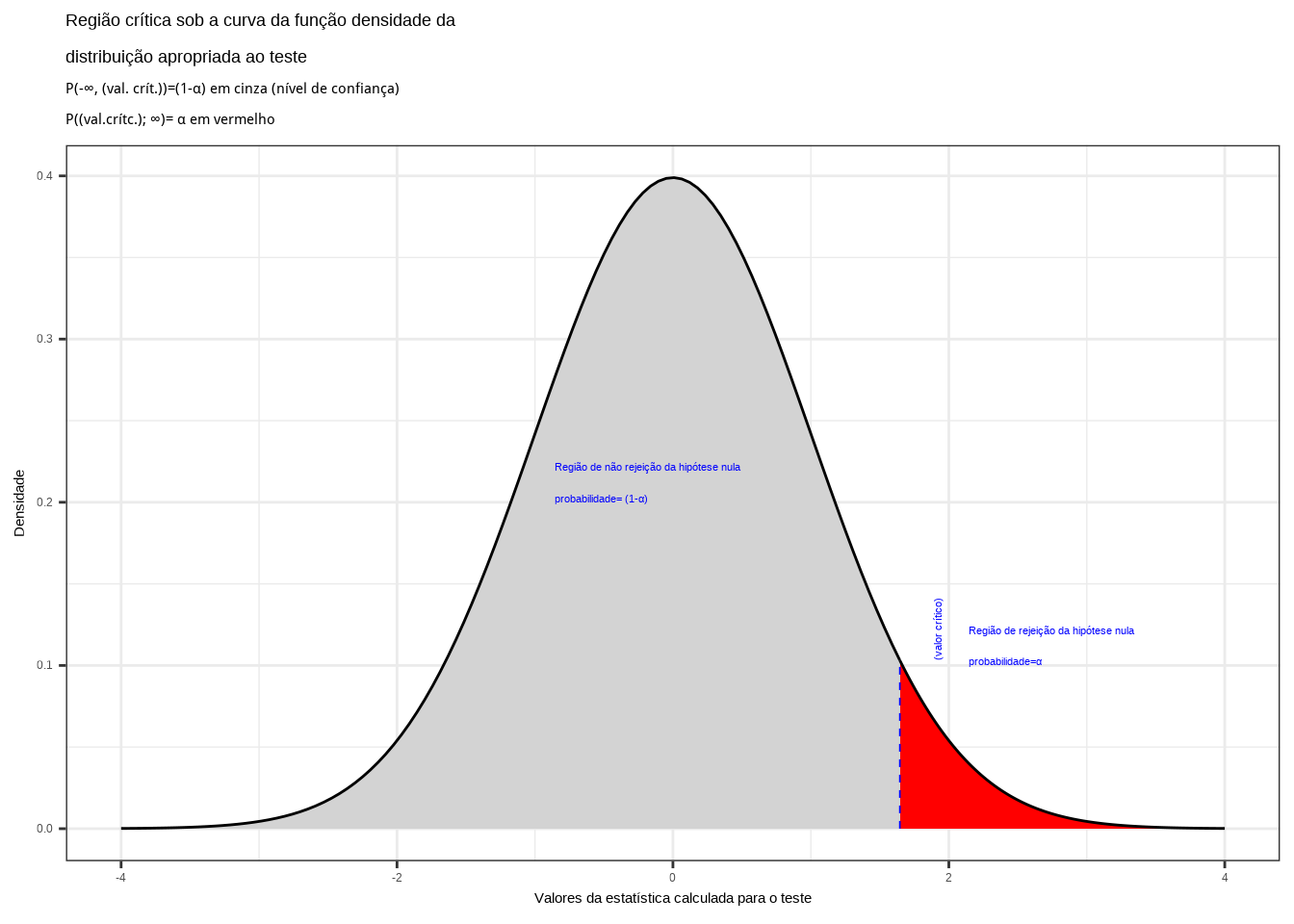

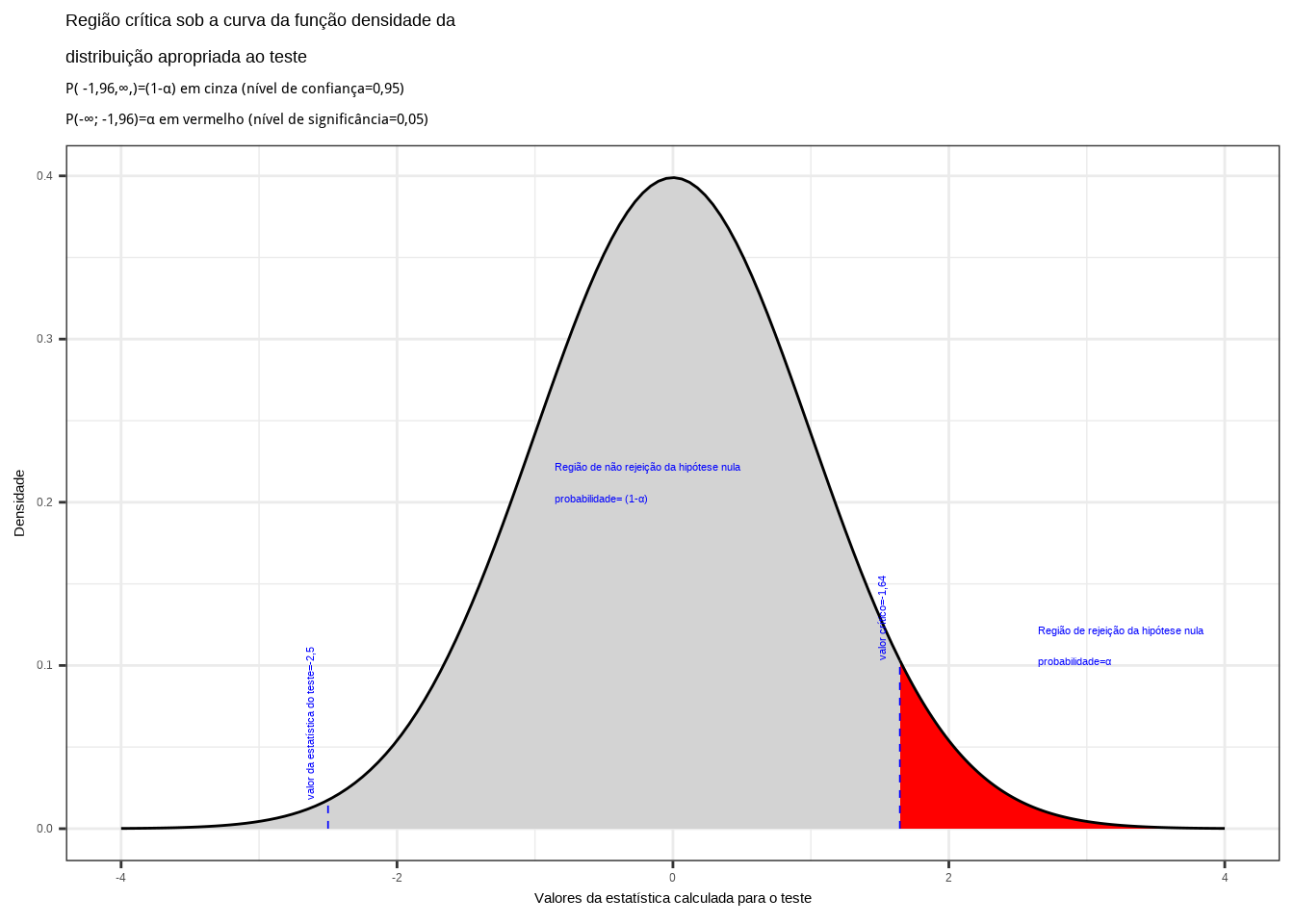

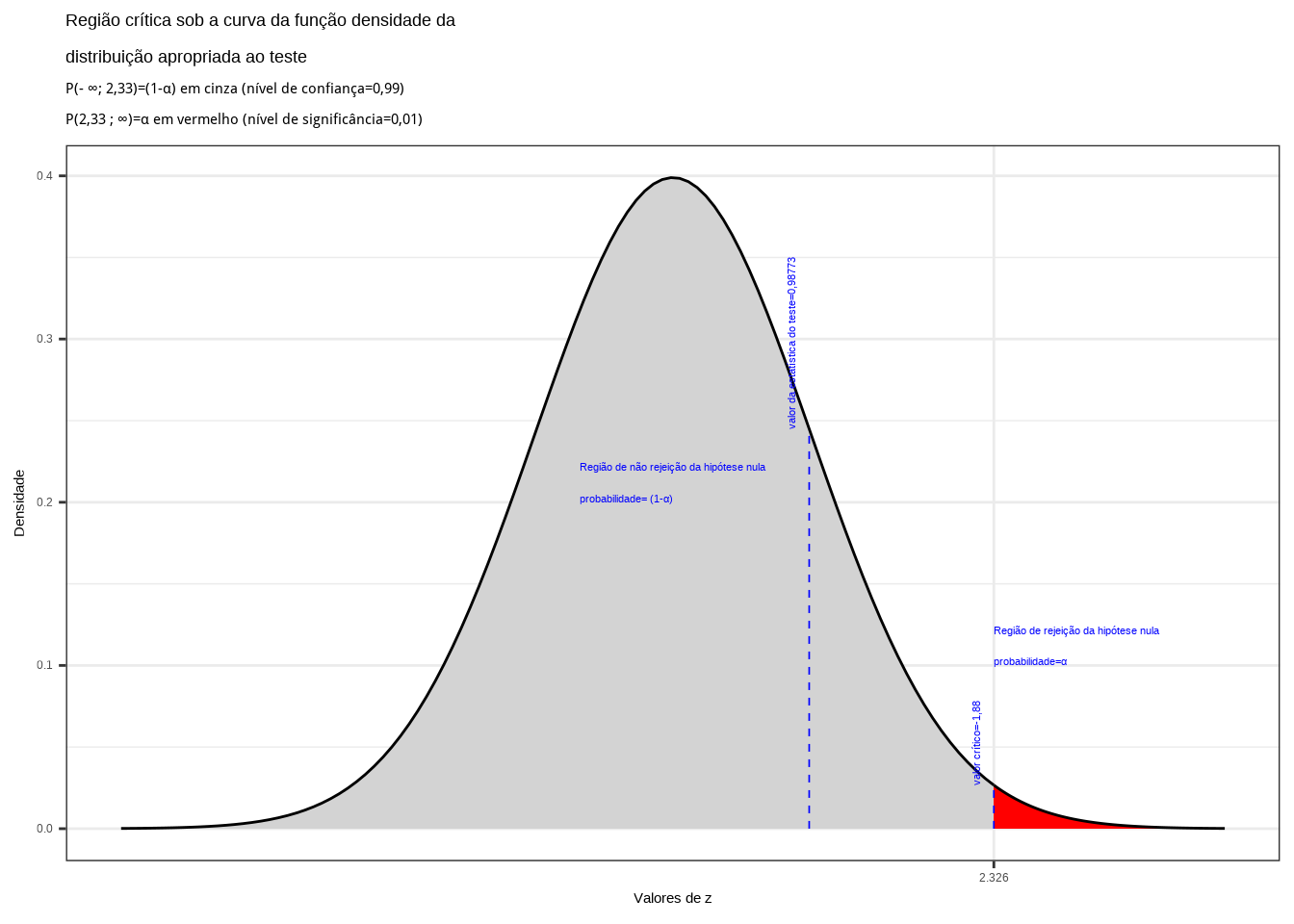

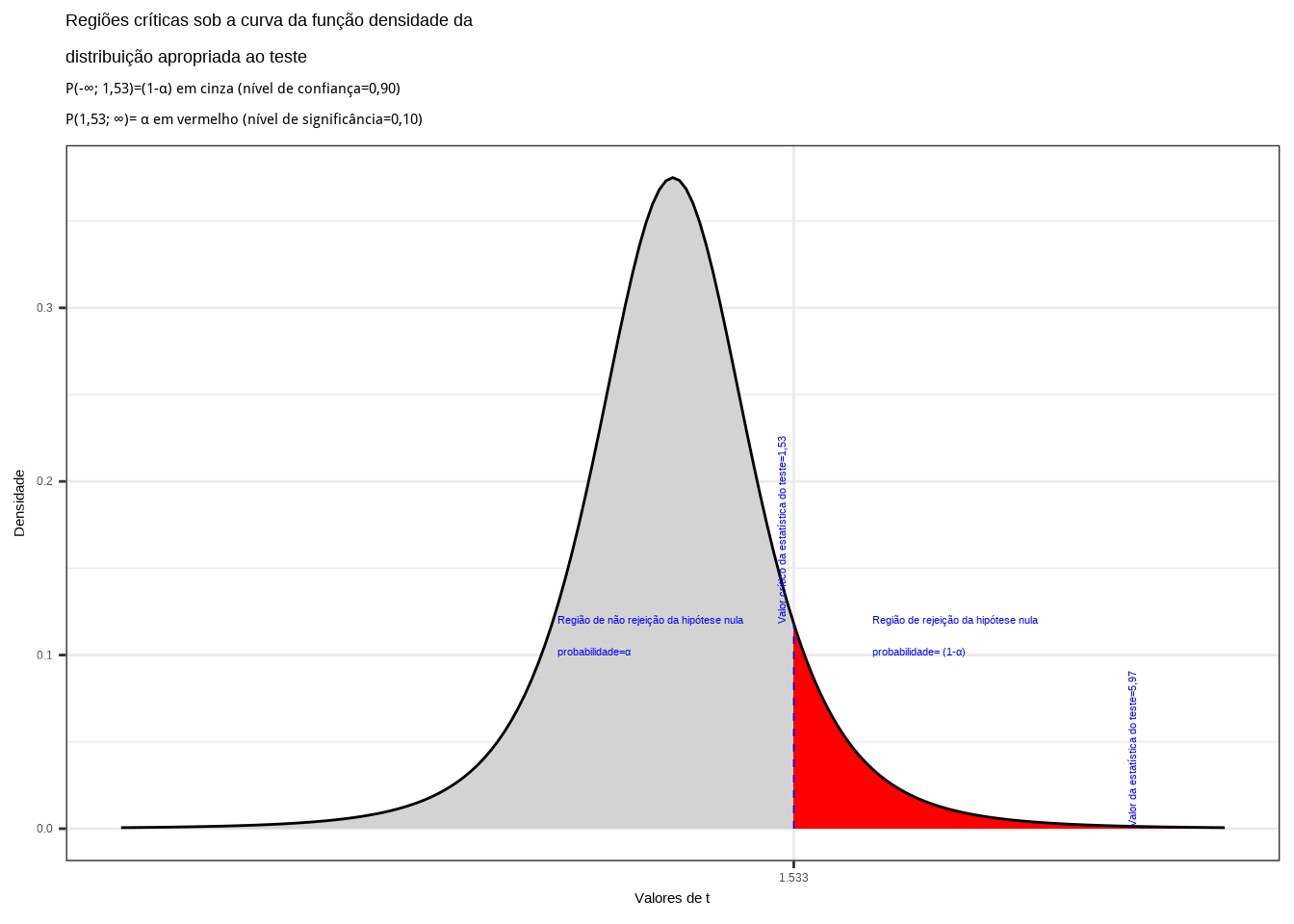

11.7.4 Teste de hipóteses Unilateral à direita

Nesse tipo de teste a hipótese aternativa é proposta como a dizer que o valor em teste não apenas é diferente, mas é maior do que aquele afirmado pela hipótese nula (conservadora):

\[ \begin{cases} H_{0}: \mu \le \mu_{0}\\ H_{1}: \mu > \mu_{0}\\ \end{cases} \]

em que \(\mu_{0}\) é um valor conservador do parâmetro \(\mu\) que se deseja testar .

alfa=0.95

prob_desejada=alfa

z_desejado=round(qnorm(prob_desejada),4)

d_desejada=dnorm(z_desejado, 0, 1)

ggplot(NULL, aes(c(-4,4))) +

geom_area(stat = "function",

fun = dnorm,

fill = "lightgrey",

xlim = c(-4, z_desejado),

colour="black") +

geom_area(stat = "function",

fun = dnorm,

fill = "red",

xlim = c(z_desejado,4),

colour="black") +

scale_y_continuous(name="Densidade") +

scale_x_continuous(name="Valores da estatística calculada para o teste") +

labs(title=

"Região crítica sob a curva da função densidade da \ndistribuição apropriada ao teste",

subtitle = "P(-\U221e, (val. crít.))=(1-\u03b1) em cinza (nível de confiança) \nP((val.crítc.); \U221e)= \u03b1 em vermelho ")+

geom_segment(aes(x = z_desejado, y = 0, xend = z_desejado, yend = d_desejada), color="blue", lty=2, lwd=0.3)+

annotate(geom="text", x=z_desejado+0.3, y=d_desejada, label="(valor crítico)", angle=90, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=z_desejado+0.5, y=0.1, label="Região de rejeição da hipótese nula \nprobabilidade=\u03b1", angle=0, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=z_desejado-2.5, y=0.2, label="Região de não rejeição da hipótese nula \nprobabilidade= (1-\u03b1)", angle=0, vjust=0, hjust=0, color="blue",size=3)+

theme_bw()

Figure 11.10: Região crítica além da qual a probabilidade associada aos valores amostrais observados é inferior a \(\alpha\), estabelecendo assim um intervalo com nível de confiança igual a \((1-\alpha)\)

Na Figura 11.10 observa-se:

- a região de rejeição da hipótese nula delimitada sob a curva da função densidade de probabilidade da distribuição adequada ao teste com probabilidade igual ao nível de significância \(\alpha\) ;

- a região de não rejeição da hipótese nula (delimitada à direita) com probabilidade igual ao nível de confiança \((1-\alpha)\); e,

- os valores críticos da estatística do teste.

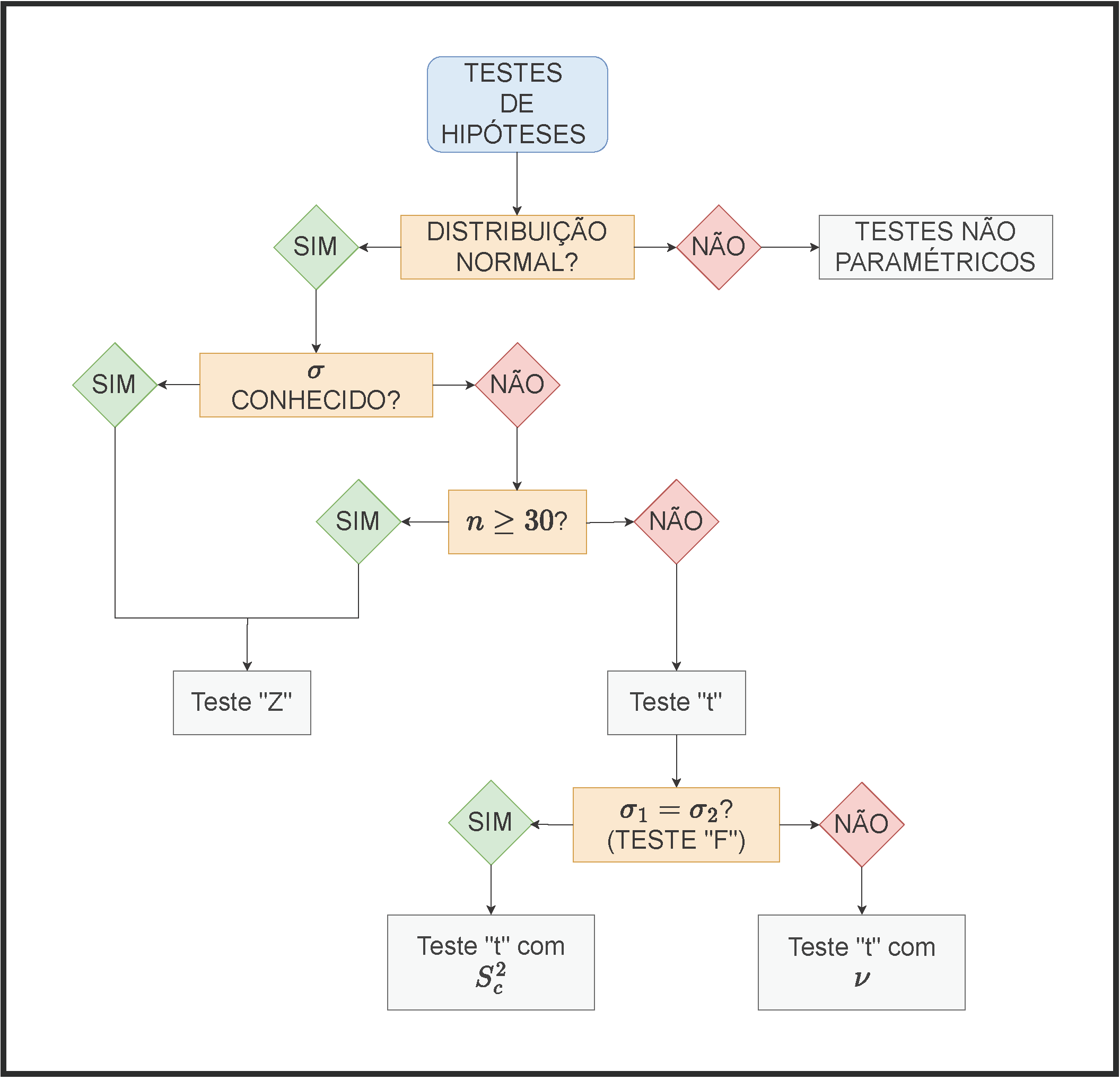

11.8 Teste de hipóteses para uma média \(\mu\)

11.8.1 Cenários possíveis

- variância populacional (\(\sigma^2\)) teoricamente conhecida;

- variância populacional (\(\sigma^2\)) desconhecida, mas o tamanho da amostra (\(n\)) é grande: \(n\ge 30\); e,

- variância populacional (\(\sigma\)) desconhecida e as amostras de tamanho (\(n\)) reduzido: \(n < 30\).

Estatística do teste para a primeira situação: variância populacional conhecida

\[

Z = \frac{\stackrel{-}{X} - \mu}{\frac{\sigma}{\sqrt{n}}} \sim \mathcal{N}(0,1)

\]

em que:

- \(\stackrel{-}{X}\) é a média observada na amostra;

- \(\mu\) o valor (desconhecido) inferido à média populacional, a ser testado frente à média amostral observada;

- \(\sigma\) é o desvio padrão populacional; e,

- \(n\) é o tamanho da amostra.

Estatística do teste para a segunda situação: variância populacional desconhecida mas amostras grandes: \(n\ge30(40)\): \(S\) pode ser tomado como estimativa de \(\sigma\):

\[ Z = \frac{\stackrel{-}{X} - \mu}{\frac{S}{\sqrt{n}}} \sim \mathcal{N}(0,1) \]

em que:

- \(\stackrel{-}{X}\) é a média observada na amostra;

- \(\mu\) o valor (desconhecido) inferido à média populacional a ser testado frente à média amostral observada;

- \(S\) é o desvio padrão amostral; e,

- \(n\) é o tamanho da amostra.

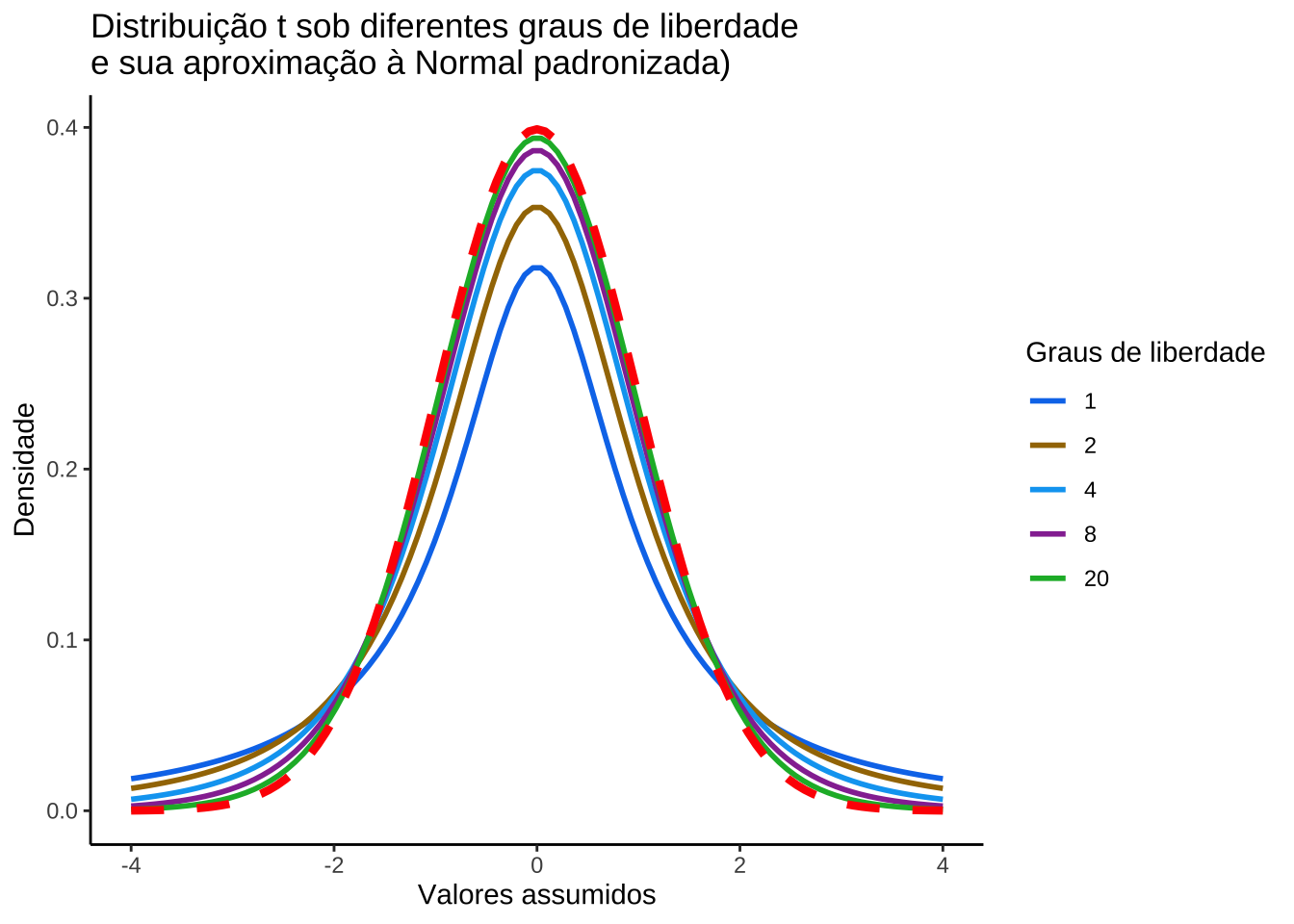

Estatística do teste para a terceira situação: variância populacional desconhecida e amostras pequenas: \(n<30\):

\[ T = \frac{(\stackrel{-}{X} - \mu)}{ \frac{S}{\sqrt{n}} } \sim t_{(n-1)} \]

em que:

- \(\stackrel{-}{X}\) é a média observada na amostra;

- \(\mu\) o valor (desconhecido) inferido à média populacional, a ser testado frente à média amostral;

- \(S\) é o desvio padrão amostral; e,

- \(n\) é o tamanho da amostra.

# Definição do eixo x

x <- seq(-4, 4, length.out = 100)

# Densidade da distribuição normal padrão

y_norm <- dnorm(x, mean = 0, sd = 1)

# Lista com diferentes graus de liberdade

df_list=c(1, 2, 4, 8, 20)

# Lista com cores para as curvas da distribuição t

colors=c("#097aeb", "#a37602", "#02a6f2", "#9635a1", "#16b533")

# Criação do data frame com todas as curvas

data=data.frame()

for (i in seq_along(df_list)) {

df = df_list[i]

y_t = dt(x, df)

df_data = data.frame(x, y_t, df)

data = rbind(data, df_data)

}

# Plotagem do gráfico

p = ggplot(data, aes(x = x)) +

geom_line(aes(y = y_t, color = factor(df)), size = 1) +

scale_color_manual(values = colors, name = "Graus de liberdade")+

ggtitle("Distribuição t sob diferentes graus de liberdade \ne sua aproximação à Normal padronizada)") +

xlab("Valores assumidos") +

ylab("Densidade") +

theme_classic() +

stat_function(fun = dnorm, args = list(mean = 0, sd = 1), color = "red", size=1.5, linetype='dashed')

print(p)

11.8.2 Roteiro geral

- identificar o modelo de probabilidade do estimador do parâmetro da população que se estuda;

- identificar a estatística apropriada para o teste em razão das informações disponíveis acerca da população, do tamanho da amostra e sua independência:

- escore médio;

- proporção;

- estatísticas T, Z, F, ou \(\chi\);

- determinar na curva de densidade de probabilidade do modelo da estatística de teste a(s) região(ões) crítica(s): faixa(s) de valores da estatística que nos levam à rejeição ou não da hipótese \(H_{0}\) em função do nível de significância previamente arbitrado pelo pesquisador \(\alpha\);

- calcular a estatística do teste apropriada para o parâmetro que se pretende inferir com base na amostra extraída;

- concluir com base nos resultados analisados: se o valor da estatística do teste pertence à(s) região(ões) crítica(s) de sua distribuição teórica, rejeitar \(H_{0}\); caso contrário não há evidências estatisticamente significativas para rejeitá-la.

11.8.3 Probabilidade dos intervalos de confiança para os testes de hipóteses com o uso da estatística Z (\(Z \sim \mathcal{N}(0,1)\)):

- Teste de hipóteses bilateral (tipo: diferente de):

\[\begin{align*} P[\left|Z_{calc}\right| \le {Z}_{tab\left(\frac{\alpha }{2}\right)}|\mu=\mu_{0}] & =(1-\alpha)\\ P(-{Z}_{tab\left(\frac{\alpha }{2}\right)} \le Z_{calc} \le {Z}_{tab\left(\frac{\alpha }{2}\right)}) & = (1-\alpha)\\ \end{align*}\]

- Teste de hipóteses unilateral à esquerda (tipo: menor que):

\[\begin{align*} P[Z_{calc} \ge -{Z}_{tab\left(\alpha \right)}|\mu \ge \mu_{0}] & =(1-\alpha) \\ P(Z_{calc} \ge -{Z}_{tab\left(\alpha \right)}) & =(1-\alpha)\\ \end{align*}\]

- Teste de hipóteses unilateral à direita (tipo maior que):

\[\begin{align*} P[Z_{calc} \le {Z}_{tab\left(\alpha \right)}|\mu \le \mu_{0}] & =(1-\alpha)\\ P(Z_{calc} \le {Z}_{tab\left(\alpha \right)}) & =(1-\alpha)\\ \end{align*}\]

11.8.4 Probabilidade dos intervalos de confiança para os testes de hipóteses com o uso da estatística T (\(T\sim t_{(n-1)}\)):

- Teste de hipóteses bilateral (tipo: diferente de):

\[\begin{align*} P[\left|t_{calc}\right| \ge {t}_{tab\left(\frac{\alpha }{2};n-1\right)}|\mu=\mu_{0}] & =(1-\alpha)\\ P(-{t}_{tab\left(\frac{\alpha }{2};n-1\right)} \le t_{calc} \le {t}_{tab\left(\frac{\alpha }{2};n-1\right)}) & =(1-\alpha) \end{align*}\]

- Teste de hipóteses unilateral à esquerda (tipo: menor que):

\[\begin{align*} P[t_{calc} \ge -{t}_{tab\left(\alpha \right)}|\mu \ge \mu_{0}] & =(1-\alpha)\\ P( t_{calc} \ge -{t}_{tab\left(\alpha;n-1\right)}) & = (1-\alpha) \end{align*}\]

- Teste de hipóteses unilateral à direita (tipo: maior que):

\[\begin{align*} P[t_{calc} \le {t}_{tab\left(\alpha \right)}|\mu \le \mu_{0}] & =(1-\alpha) \\ P( t_{calc} \le {t}_{tab\left(\alpha;n-1\right)} ) & = (1-\alpha) \end{align*}\]

Exemplo: O tempo de vida útil de uma amostra de 100 lâmpadas fluorescentes produzidas por uma fábrica foi calculado resultando em uma vida útil média de 1570 h sob um desvio padrão de 120 h. Seja \(\mu\) é o tempo de vida útil das lâmpadas produzidas pela empresa. Teste a hipótese de \(\mu=1600 h\) contra a hipótese alternativa de \(\mu \neq 1600 h\) sob um nível de significância \(\alpha=0,05\).

O problema nos pede um teste bilateral (tipo: diferente de):

\[ \begin{cases} H_{0}: \mu = 1.600\\ H_{1}: \mu \ne 1.600\\ \end{cases} \]

Iremos verificar se a informação amostral obtida nos permite rejeitar a hipótese nula que afirma ser a vida útil média das lâmpadas a 1.600 h., fazendo então valer a hipótese alternativa que afirma ser a vida útil das lâmpadas diferente de 1.600 h.

Pelo enunciado do problema a variância populacional \(\sigma^{2}\) é desconhecida mas, como a amostra é de grande tamanho (n=100) podemos tomar \(S\) como uma estimativa de \(\sigma\) e a estatística do teste fica definida como sendo:

\[ Z = \frac{\stackrel{-}{X} - \mu_{0}}{\frac{S}{\sqrt{n}}} \sim \mathcal{N}(0,1) \]

Extraindo os dados do problema:

- \(\stackrel{-}{X}=1570h\) é a média amostral;

- \(\mu_{0}=1600\) o valor (desconhecido) inferido à média populacional a ser testado frente à média amostral;

- \(S=120h\) é o desvio padrão amostral; e,

- \(n=100\) é o tamanho da amostra.

Calculando-se o valor da estatística do teste:

\[ z_{calc} = \frac{1570 - 1600}{\frac{120}{\sqrt{100}} } =-2,50 \]

Da tabela da distribuição Normal reduzida obtemos o valor crítico bicaudal: \(|{z}_{crit}|=1,96\). Pelo cálculo, a estatística do teste é \(z_{calc}=-2,50\).

alfa=0.05

prob_desejada1=alfa/2

z_desejado1=round(qnorm(prob_desejada1),4)

d_desejada1=dnorm(z_desejado1, 0, 1)

prob_desejada2=1-alfa/2

z_desejado2=round(qnorm(prob_desejada2),4)

d_desejada2=dnorm(z_desejado2, 0, 1)

z_calculado=-2.5

d_calculado=dnorm(z_calculado, 0, 1)

ggplot(NULL, aes(c(-4,4))) +

geom_area(stat = "function",

fun = dnorm,

fill = "red",

xlim = c(-4, z_desejado1),

colour="black") +

geom_area(stat = "function",

fun = dnorm,

fill = "lightgrey",

xlim = c(z_desejado1,0),

colour="black") +

geom_area(stat = "function",

fun = dnorm,

fill = "lightgrey",

xlim = c(0, z_desejado2),

colour="black") +

geom_area(stat = "function",

fun = dnorm,

fill = "red",

xlim = c(z_desejado2,4),

colour="black") +

scale_y_continuous(name="Densidade") +

scale_x_continuous(name="Valores de z", breaks = c(z_desejado1,z_desejado2)) +

labs(title=

"Regiões críticas sob a curva da função densidade da \ndistribuição apropriada ao teste",

subtitle = "P(-1,96, 1,96)=(1-\u03b1) em cinza (nível de confiança=0,95) \nP(-\U221e; -1,96)= P(1,96; \U221e)= \u03b1/2 em vermelho (nível de significância/2=0,025) ")+

geom_segment(aes(x = z_desejado1, y = 0, xend = z_desejado1, yend = d_desejada1), color="blue", lty=2, lwd=0.3)+

geom_segment(aes(x = z_desejado2, y = 0, xend = z_desejado2, yend = d_desejada2), color="blue", lty=2, lwd=0.3)+

annotate(geom="text", x=z_desejado1-0.1, y=d_desejada1, label="valor crítico=-1,96", angle=90, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=z_desejado2+0.3, y=d_desejada2, label="valor crítico=1,96", angle=90, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=z_desejado1-2, y=0.1, label="Região de rejeição da hipótese nula \nprobabilidade=\u03b1/2", angle=0, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=z_desejado2+0.5, y=0.1, label="Região de rejeição da hipótese nula \nprobabilidade=\u03b1/2", angle=0, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=z_desejado1+1.3, y=0.2, label="Região de não rejeição da hipótese nula \nprobabilidade= (1-\u03b1)", angle=0, vjust=0, hjust=0, color="blue",size=3)+

geom_segment(aes(x = z_calculado, y = 0, xend = z_calculado, yend = d_calculado), color="blue", lty=2, lwd=0.3)+

annotate(geom="text", x=z_calculado-0.1, y=d_calculado, label="valor da estatística do teste=-2,5", angle=90, vjust=0, hjust=0, color="blue",size=3)+

theme_bw()

Figure 11.11: Regiões de rejeição da hipótese nula para o teste bilateral (tipo: diferente de) realizado: a região de não rejeição da hipótese nula (região de não significância do teste) está delimitada pelos valores críticos da estatística do teste: \(z_{crit} =\pm 1,96\). O valor calculado da estatística (\(z_{calc}=-2,50\)) situa-se na faixa de significância do teste, possibilitando a rejeição da hipótese nula sob aquele nível de confiança

Conclusão: Os resultados obtidos na análise estatística realizada nos permitem rejeitar a hipótese de que a duração média populacional das lâmpadas seja igual a 1600h sob um nível de confiança de 95%. A vida útil média das lâmpadas é diferente de 1600h (Figura 11.11).

Podemos ainda realizar testes de hipóteses unilaterais (\(\mu<\mu_{0}\) ou \(\mu>\mu_{0}\)).

Teste unilateral à esquerda (tipo: menor que)

\[ \begin{cases} H_{0}: \mu \ge 1.600 \\ H_{1}: \mu < 1.600 \\ \end{cases} \]

Iremos verificar se a informação amostral obtida nos permite rejeitar a hipótese nula que afirma ser a vida útil média das lâmpadas igual ou superior a 1.600 h., fazendo então valer a hipótese alternativa que afirma ser a vida útil das lâmpadas menor que 1.600 h.

Da tabela da distribuição Normal reduzida obtemos o valor crítico monocaudal: \({z}_{crit}=-1,64\). Pelo cálculo, a estatística do teste é \(z_{calc}=-2,50\).

alfa=0.05

prob_desejada=alfa

z_desejado=round(qnorm(prob_desejada),4)

d_desejada=dnorm(z_desejado, 0, 1)

z_calculado=-2.5

d_calculado=dnorm(z_calculado, 0, 1)

ggplot(NULL, aes(c(-4,4))) +

geom_area(stat = "function",

fun = dnorm,

fill = "red",

xlim = c(-4, z_desejado),

colour="black") +

geom_area(stat = "function",

fun = dnorm,

fill = "lightgrey",

xlim = c(z_desejado,0),

colour="black") +

geom_area(stat = "function",

fun = dnorm,

fill = "lightgrey",

xlim = c(0, z_desejado),

colour="black") +

geom_area(stat = "function",

fun = dnorm,

fill = "lightgrey",

xlim = c(z_desejado,4),

colour="black") +

scale_y_continuous(name="Densidade") +

scale_x_continuous(name="Valores da estatística calculada para o teste") +

labs(title=

"Região crítica sob a curva da função densidade da \ndistribuição apropriada ao teste",

subtitle = "P( -1,64,\U221e,)=(1-\u03b1) em cinza (nível de confiança=0,95) \nP(-\U221e; -1,64)=\u03b1 em vermelho (nível de significância=0,05) ")+

geom_segment(aes(x = z_desejado, y = 0, xend = z_desejado, yend = d_desejada), color="blue", lty=2, lwd=0.3)+

annotate(geom="text", x=z_desejado-0.1, y=d_desejada, label="valor crítico=-1,64", angle=90, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=z_desejado-2.5, y=0.1, label="Região de rejeição da hipótese nula \nprobabilidade=\u03b1", angle=0, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=z_desejado+1, y=0.2, label="Região de não rejeição da hipótese nula \nprobabilidade= (1-\u03b1)", angle=0, vjust=0, hjust=0, color="blue",size=3)+

geom_segment(aes(x = z_calculado, y = 0, xend = z_calculado, yend = d_calculado), color="blue", lty=2, lwd=0.3)+

annotate(geom="text", x=z_calculado-0.1, y=d_calculado, label="valor da estatística do teste=-2,5", angle=90, vjust=0, hjust=0, color="blue",size=3)+

theme_bw()

Figure 11.12: Região de rejeição da hipótese nula para o teste unilateral à esquerda (tipo: menor que) realizado: a região de não rejeição da hipótese nula (região de não significância do teste) está delimitada pelo valor crítico da estatística do teste: \(z_{crit} = -1,64\). O valor calculado da estatística (\(z_{calc}=-2,50\)) situa-se na faixa de significância do teste, possibilitando a rejeição da hipótese nula sob aquele nível de confiança

Conclusão: Os resultados obtidos na análise estatística realizada nos permitem rejeitar a hipótese de que a duração média populacional das lâmpadas seja igual ou superior a 1600h sob um nível de confiança de 95%. A vida útil média é menor que 1600h (Figura 11.12).

Teste unilateral à direita (tipo: maior que)

\[ \begin{cases} H_{0}: \mu \le 1.600 \\ H_{1}: \mu > 1.600 \\ \end{cases} \]

Iremos verificar se a informação amostral obtida nos permite rejeitar a hipótese nula que afirma ser a vida útil média das lâmpadas igual ou inferior a 1.600 h., fazendo então valer a hipótese alternativa que afirma ser a vida útil das lâmpadas maior que 1.600 h.

Da tabela da distribuição Normal reduzida obtemos o valor crítico monocaudal: \({z}_{crit}=1,64\). Pelo cálculo, a estatística do teste é \(z_{calc}=-2,50\).

alfa=0.95

prob_desejada=alfa

z_desejado=round(qnorm(prob_desejada),4)

d_desejada=dnorm(z_desejado, 0, 1)

z_calculado=-2.5

d_calculado=dnorm(z_calculado, 0, 1)

ggplot(NULL, aes(c(-4,4))) +

geom_area(stat = "function",

fun = dnorm,

fill = "lightgrey",

xlim = c(-4, z_desejado),

colour="black") +

geom_area(stat = "function",

fun = dnorm,

fill = "red",

xlim = c(z_desejado,4),

colour="black") +

scale_y_continuous(name="Densidade") +

scale_x_continuous(name="Valores da estatística calculada para o teste") +

labs(title=

"Região crítica sob a curva da função densidade da \ndistribuição apropriada ao teste",

subtitle = "P( -1,96,\U221e,)=(1-\u03b1) em cinza (nível de confiança=0,95) \nP(-\U221e; -1,96)=\u03b1 em vermelho (nível de significância=0,05) ")+

geom_segment(aes(x = z_desejado, y = 0, xend = z_desejado, yend = d_desejada), color="blue", lty=2, lwd=0.3)+

annotate(geom="text", x=z_desejado-0.1, y=d_desejada, label="valor crítico=-1,64", angle=90, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=z_desejado+1, y=0.1, label="Região de rejeição da hipótese nula \nprobabilidade=\u03b1", angle=0, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=z_desejado-2.5, y=0.2, label="Região de não rejeição da hipótese nula \nprobabilidade= (1-\u03b1)", angle=0, vjust=0, hjust=0, color="blue",size=3)+

geom_segment(aes(x = z_calculado, y = 0, xend = z_calculado, yend = d_calculado), color="blue", lty=2, lwd=0.3)+

annotate(geom="text", x=z_calculado-0.1, y=d_calculado, label="valor da estatística do teste=-2,5", angle=90, vjust=0, hjust=0, color="blue",size=3)+

theme_bw()

Figure 11.13: Região de rejeição da hipótese nula para o teste unilateral à direita (tipo: maior que) realizado: a região de não rejeição da hipótese nula (região de não significância do teste) está delimitada pelo valor crítico da estatística do teste: \(z_{crit} = 1,64\). O valor calculado da estatística (\(z_{calc}=-2,50\)) situa-se na faixa de não significância do teste, não possibilitando a rejeição da hipótese nula sob aquele nível de confiança

Conclusão: Os resultados obtidos na análise estatística realizada não nos permitem rejeitar a hipótese de que a duração média populacional das lâmpadas seja igual ou inferior a 1600h sob um nível de confiança de 95%. A vida útil média é maior que 1600h (Figura 11.12).

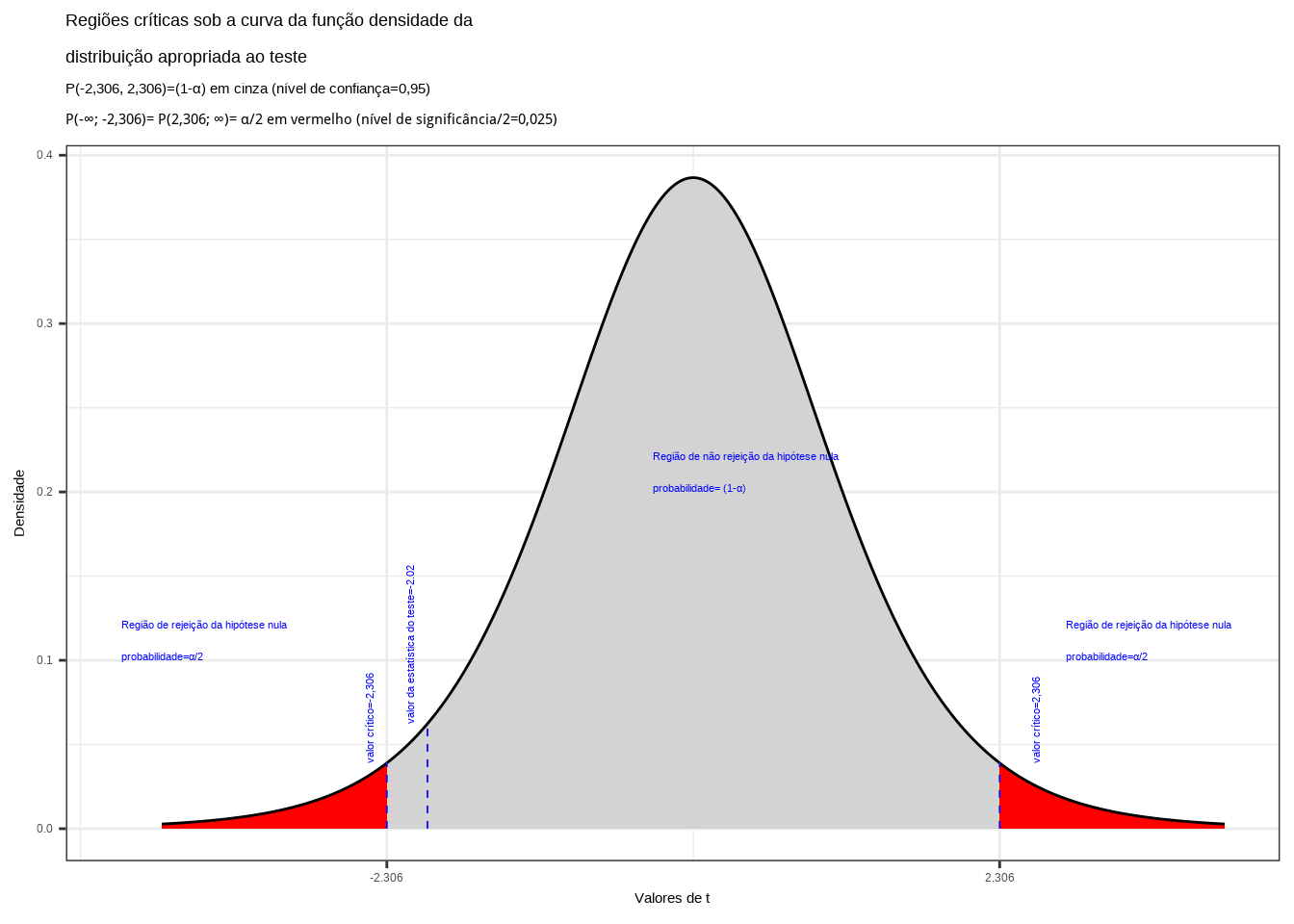

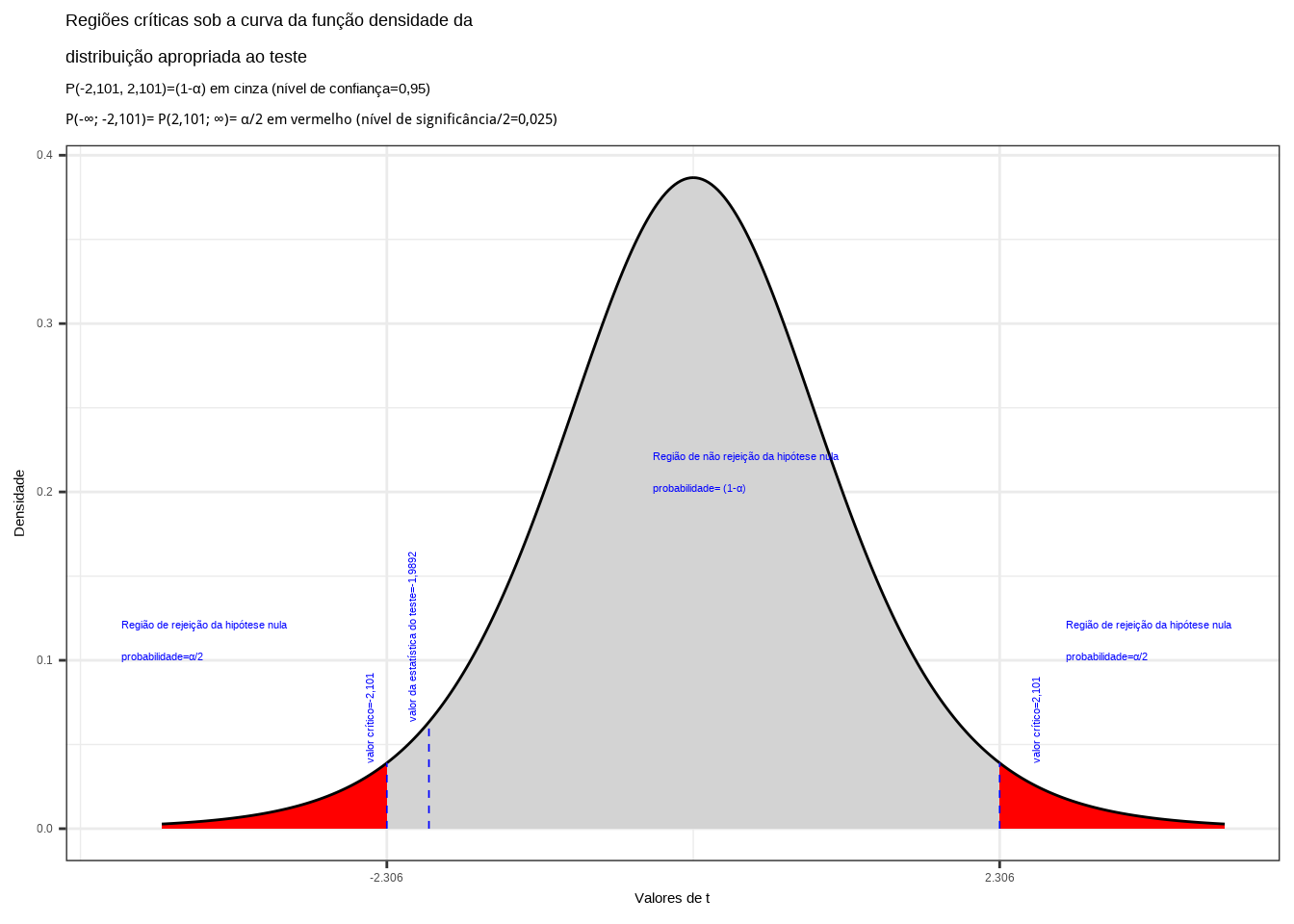

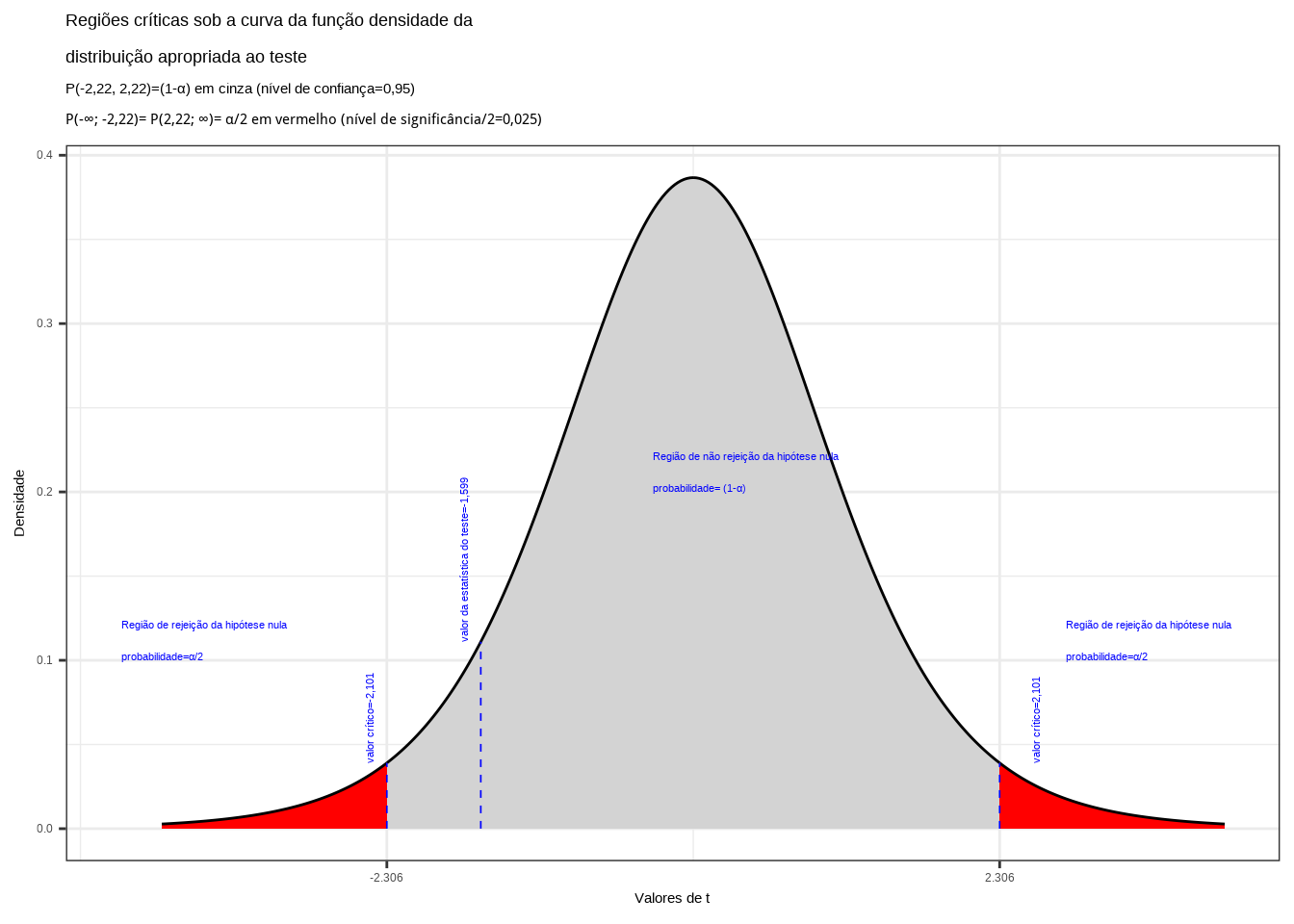

Exemplo: De um universo Normal com parâmetros média e variância (\(\mu\) e \(\sigma^{2}\)) desconhecidos, retirou-se uma amostra aleatória composta por 9 observações que apresentou as seguintes sínteses numéricas: \(\stackrel{-}{X} = 4\) e \(S^{2} = 2,2\). Proceda ao seguinte teste de hipóteses, a um nível de significância: \(\alpha=0,05\), de que a média populacional é igual a 5.

O problema nos pede um teste bilateral (tipo: diferente de):

\[ \begin{cases} H_{0}: \mu = 5\\ H_{1}: \mu \ne 5\\ \end{cases} \]

Iremos verificar se a informação amostral obtida nos permite rejeitar a hipótese nula que afirma ser a média igual a 5, fazendo então valer a hipótese alternativa que afirma ser a média diferente de 5.

Pelo enunciado do problema a variância populacional \(\sigma^{2}\) é desconhecida e a amostra é pequena (n=9). Nessa situação, a estatística do teste fica definida como sendo:

\[ T = \frac{(\stackrel{-}{X} - \mu_{0})}{ \frac{s}{\sqrt{n}} } \sim t_{(n-1)} \]

Extraindo os dados do problema:

- \(\stackrel{-}{x}=4\) é a média amostral;

- \(\mu_{0}=5\) o valor (desconhecido) inferido à média populacional, a ser testado frente à média amostral;

- \(s = \sqrt{2,2}=1,48\) é o desvio padrão da amostra extraída;

- \(n = 9\) é o tamanho da amostra extraída;

Calculando-se o valor da estatística do teste:

\[ t_{calc} = \frac{(\stackrel{-}{X} - \mu_{0})}{ \frac{s}{\sqrt{n}} } = -2,02 \]

Da tabela ``t’’ de Student obtemos o valor crítico bicaudal: \(|{t}_{tab\left(\frac{\alpha }{2}\right), (n-1)}|=2,306\). Pelo cálculo a estatística do teste é \(t_{calc}=-2,02\).

alfa=0.05

prob_desejada1=alfa/2

df=8

t_desejado1=round(qt(prob_desejada1,df ),df)

d_desejada1=dt(t_desejado1,df)

prob_desejada2=1-alfa/2

df=8

t_desejado2=round(qt(prob_desejada2, df),df)

d_desejada2=dt(t_desejado2,df)

t_calculado=-2

d_calculado=dt(t_calculado,df)

ggplot(NULL, aes(c(-4,4))) +

geom_area(stat = "function",

fun = dt,

args=list(df),

fill = "red",

xlim = c(-4, t_desejado1),

colour="black") +

geom_area(stat = "function",

fun = dt,

args=list(df),

fill = "lightgrey",

xlim = c(t_desejado1,0),

colour="black") +

geom_area(stat = "function",

fun = dt,

args=list(df),

fill = "lightgrey",

xlim = c(0, t_desejado2),

colour="black") +

geom_area(stat = "function",

fun = dt,

args=list(df),

fill = "red",

xlim = c(t_desejado2,4),

colour="black") +

scale_y_continuous(name="Densidade") +

scale_x_continuous(name="Valores de t", breaks = c(t_desejado1, t_desejado2)) +

labs(title=

"Regiões críticas sob a curva da função densidade da \ndistribuição apropriada ao teste",

subtitle = "P(-2,306, 2,306)=(1-\u03b1) em cinza (nível de confiança=0,95) \nP(-\U221e; -2,306)= P(2,306; \U221e)= \u03b1/2 em vermelho (nível de significância/2=0,025) ")+ geom_segment(aes(x = t_desejado1, y = 0, xend = t_desejado1, yend = d_desejada1), color="blue", lty=2, lwd=0.3)+

geom_segment(aes(x = t_desejado2, y = 0, xend = t_desejado2, yend = d_desejada2), color="blue", lty=2, lwd=0.3)+

annotate(geom="text", x=t_desejado1-0.1, y=d_desejada1, label="valor crítico=-2,306", angle=90, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=t_desejado2+0.3, y=d_desejada2, label="valor crítico=2,306", angle=90, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=t_desejado1-2, y=0.1, label="Região de rejeição da hipótese nula \nprobabilidade=\u03b1/2", angle=0, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=t_desejado2+0.5, y=0.1, label="Região de rejeição da hipótese nula \nprobabilidade=\u03b1/2", angle=0, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=t_desejado1+2, y=0.2, label="Região de não rejeição da hipótese nula \nprobabilidade= (1-\u03b1)", angle=0, vjust=0, hjust=0, color="blue",size=3)+

geom_segment(aes(x = t_calculado, y = 0, xend = t_calculado, yend = d_calculado), color="blue", lty=2, lwd=0.3)+

annotate(geom="text", x=t_calculado-0.1, y=d_calculado, label="valor da estatística do teste=-2.02", angle=90, vjust=0, hjust=0, color="blue",size=3)+

theme_bw()

Figure 11.14: Regiões de rejeição da hipótese nula para o teste bilateral (tipo: diferente de) realizado: a região de não rejeição da hipótese nula (região de não significância do teste) está delimitada pelos valores críticos da estatística do teste: \(t_{crit} =\pm 2,306\). O valor calculado da estatística (\(t_{calc}=-2,02\)) situa-se na faixa de significância do teste, possibilitando a rejeição da hipótese nula sob aquele nível de confiança

Conclusão: Os resultados obtidos na análise estatística realizada não nos permitem rejeitar a hipótese de que a média populacional seja igual a 5 sob um nível de confiança de 95% (Figura 11.14).

# Dados do problema

n=9

media_amostral=4

var_amostral=2.2

media_populacao=5

alfa=0.05

# Estatística de teste

t=(media_amostral - media_populacao) / sqrt(var_amostral / n)

# Graus de liberdade

df=n - 1

# Valor-p à esquerda

p_valor_1=pt(-abs(t), df, lower.tail = TRUE)

# Valor-p à direita

p_valor_2=pt(abs(t), df, lower.tail = FALSE)

# p-valor

p_valor=p_valor_1+p_valor_2

# Ou

p_valor <- 2 * pt(-abs(t), df)

# Decisão e conclusão

if (p_valor < alfa) {

cat("Os dados amostrais trazidos à análise nos permitem rejeitar, sob o nível de significância estabelecido de", alfa ,"de se cometer um erro do tipo I, a hipótese nula (H0) que afirma ser a média populacional igual a", media_populacao,".A média populacional é diferente.")

} else {

cat("Os dados amostrais trazidos à análise não nos permitem rejeitar, sob o nível de confiança de", 1-alfa ,",a hipótese nula (H0). A média populacional é igual a", media_populacao,".")

}## Os dados amostrais trazidos à análise não nos permitem rejeitar, sob o nível de confiança de 0.95 ,a hipótese nula (H0). A média populacional é igual a 5 .

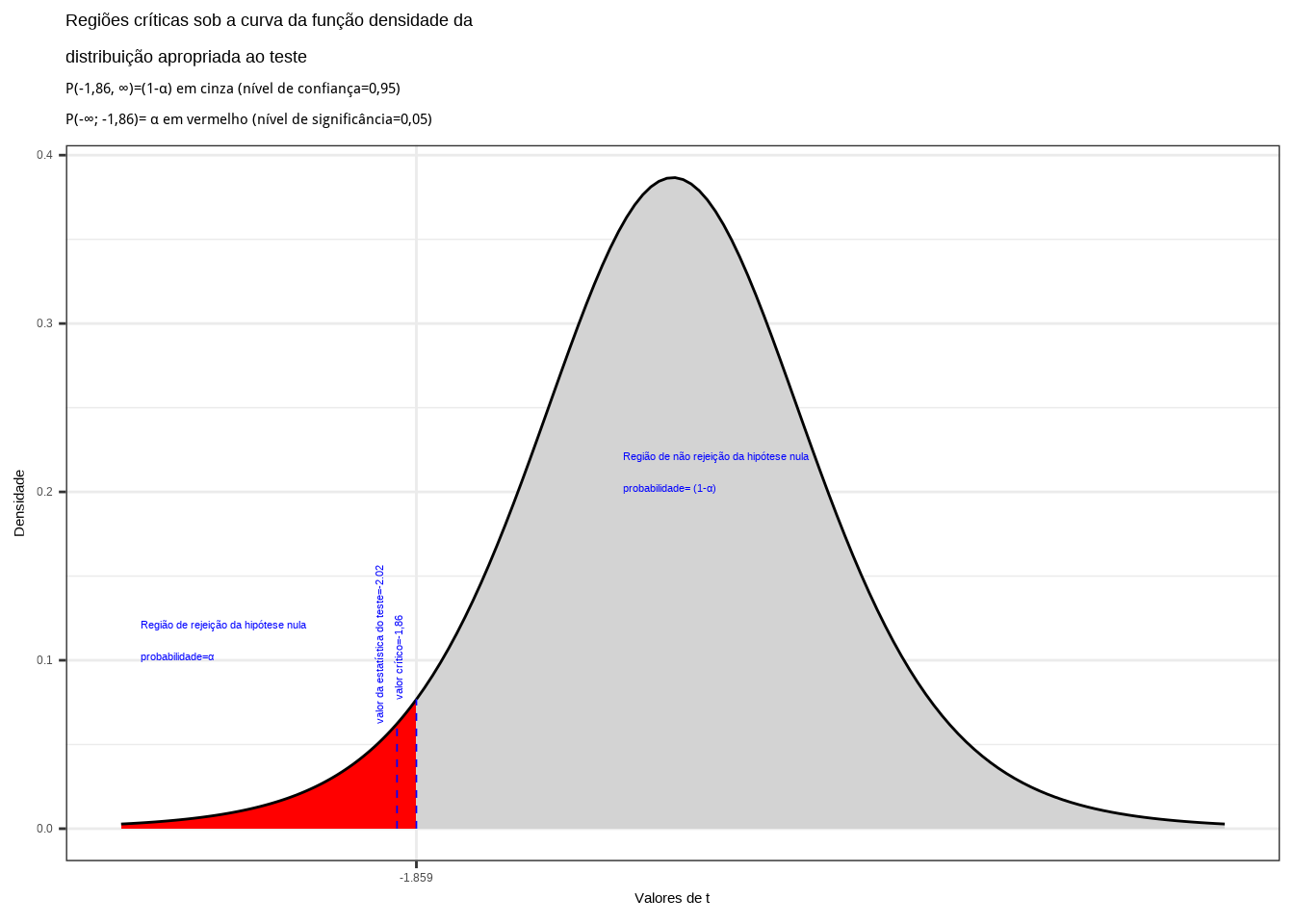

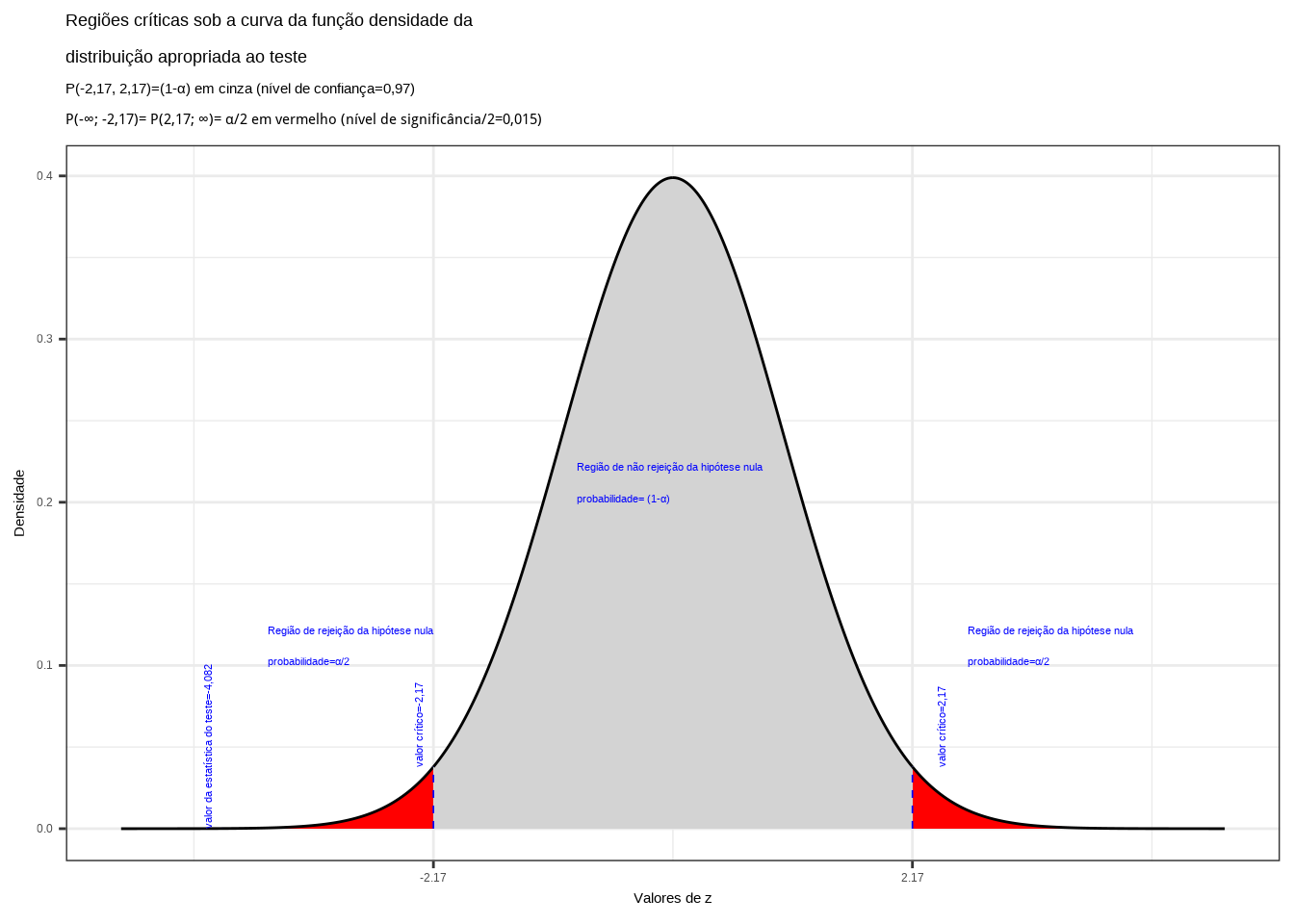

> Teste unilateral à esquerda (tipo: menor que)

\[ \begin{cases} H_{0}: \mu \ge 5\\ H_{1}: \mu < 5\\ \end{cases} \]

Iremos verificar se a informação amostral obtida nos permite rejeitar a hipótese nula que afirma ser a média igual ou maior a 5, fazendo então valer a hipótese alternativa que afirma ser a média menor que 5.

Da tabela ``t’’ de Student obtemos o valor crítico monocaudal: \(|{t}_{tab_(\alpha, (n-1))}|=-1,86\). Pelo cálculo a estatística do teste é \(t_{calc}=-2,02\).

alfa=0.05

prob_desejada=alfa

df=8

t_desejado=round(qt(prob_desejada,df ),4)

d_desejada=dt(t_desejado,df)

t_calculado=-2

d_calculado=dt(t_calculado,df)

ggplot(NULL, aes(c(-4,4))) +

geom_area(stat = "function",

fun = dt,

args=list(df),

fill = "red",

xlim = c(-4, t_desejado),

colour="black") +

geom_area(stat = "function",

fun = dt,

args=list(df),

fill = "lightgrey",

xlim = c(t_desejado,4),

colour="black") +

scale_y_continuous(name="Densidade") +

scale_x_continuous(name="Valores de t", breaks = c(t_desejado)) +

labs(title=

"Regiões críticas sob a curva da função densidade da \ndistribuição apropriada ao teste",

subtitle = "P(-1,86, \U221e)=(1-\u03b1) em cinza (nível de confiança=0,95) \nP(-\U221e; -1,86)= \u03b1 em vermelho (nível de significância=0,05) ")+

geom_segment(aes(x = t_desejado, y = 0, xend = t_desejado, yend = d_desejada), color="blue", lty=2, lwd=0.3)+

annotate(geom="text", x=t_desejado-0.1, y=d_desejada, label="valor crítico=-1,86", angle=90, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=t_desejado-2, y=0.1, label="Região de rejeição da hipótese nula \nprobabilidade=\u03b1", angle=0, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=t_desejado+1.5, y=0.2, label="Região de não rejeição da hipótese nula \nprobabilidade= (1-\u03b1)", angle=0, vjust=0, hjust=0, color="blue",size=3)+

geom_segment(aes(x = t_calculado, y = 0, xend = t_calculado, yend = d_calculado), color="blue", lty=2, lwd=0.3)+

annotate(geom="text", x=t_calculado-0.1, y=d_calculado, label="valor da estatística do teste=-2.02", angle=90, vjust=0, hjust=0, color="blue",size=3)+

theme_bw()

Figure 11.15: Região de rejeição da hipótese nula para o teste unilateral à esquerda (tipo: menor que) realizado: a região de não rejeição da hipótese nula (região de não significância do teste) está delimitada pelo valor crítico da estatística do teste: \(t_{crit} = -1,86\). O valor calculado da estatística (\(t_{calc}=-2,02\)) situa-se na faixa de significância do teste possibilitando a rejeição da hipótese nula sob aquele nível de confiança

Conclusão: sob um nível de confiança de confiança de 95%, face aos dados trazidos à análise podemos rejeitar a hipótese de que a média seja de no mínimo a 5 (Figura 11.15).

Caso estabelecêssemos um nível de confiança \((1-\alpha) \ge 0,9611277\) (ou tivéssemos uma informação amostral \(\stackrel{-}{x} \ge 4.080639\)), a hipótese nula não seria rejeitada: a média populacional é maior ou igual a 5.

# Dados do problema

n=9

media_amostral=4

var_amostral=2.2

media_populacao=5

alfa=0.05

# Estatística de teste

t=(media_amostral - media_populacao) / sqrt(var_amostral / n)

# Graus de liberdade

df=n - 1

# Valor-p à esquerda

p_valor=pt(t, df)

# Decisão e conclusão

if (p_valor < alfa) {

cat("Os dados amostrais trazidos à análise nos permitem rejeitar, sob o nível de significância estabelecido de", alfa ,"de se cometer um erro do tipo I, a hipótese nula (H0) que afirma ser a média populacional maior ou igual a ", media_populacao,".A média populacional é menor.")

} else {

cat("Os dados amostrais trazidos à análise não nos permitem rejeitar, sob o nível de confiança de", 1-alfa ,",a hipótese nula (H0). A média populacional é maior ou igual a", media_populacao,".")

}## Os dados amostrais trazidos à análise nos permitem rejeitar, sob o nível de significância estabelecido de 0.05 de se cometer um erro do tipo I, a hipótese nula (H0) que afirma ser a média populacional maior ou igual a 5 .A média populacional é menor.

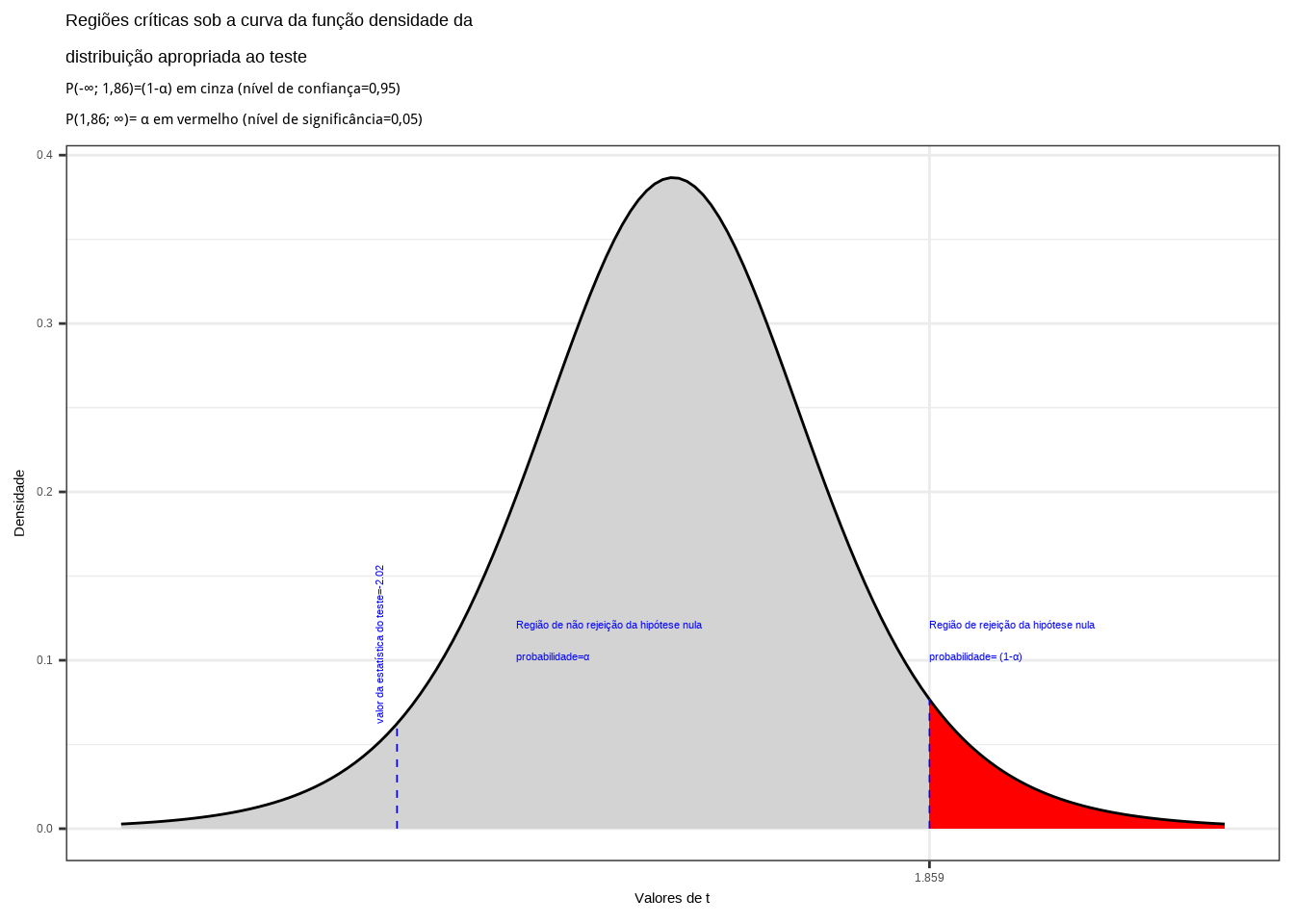

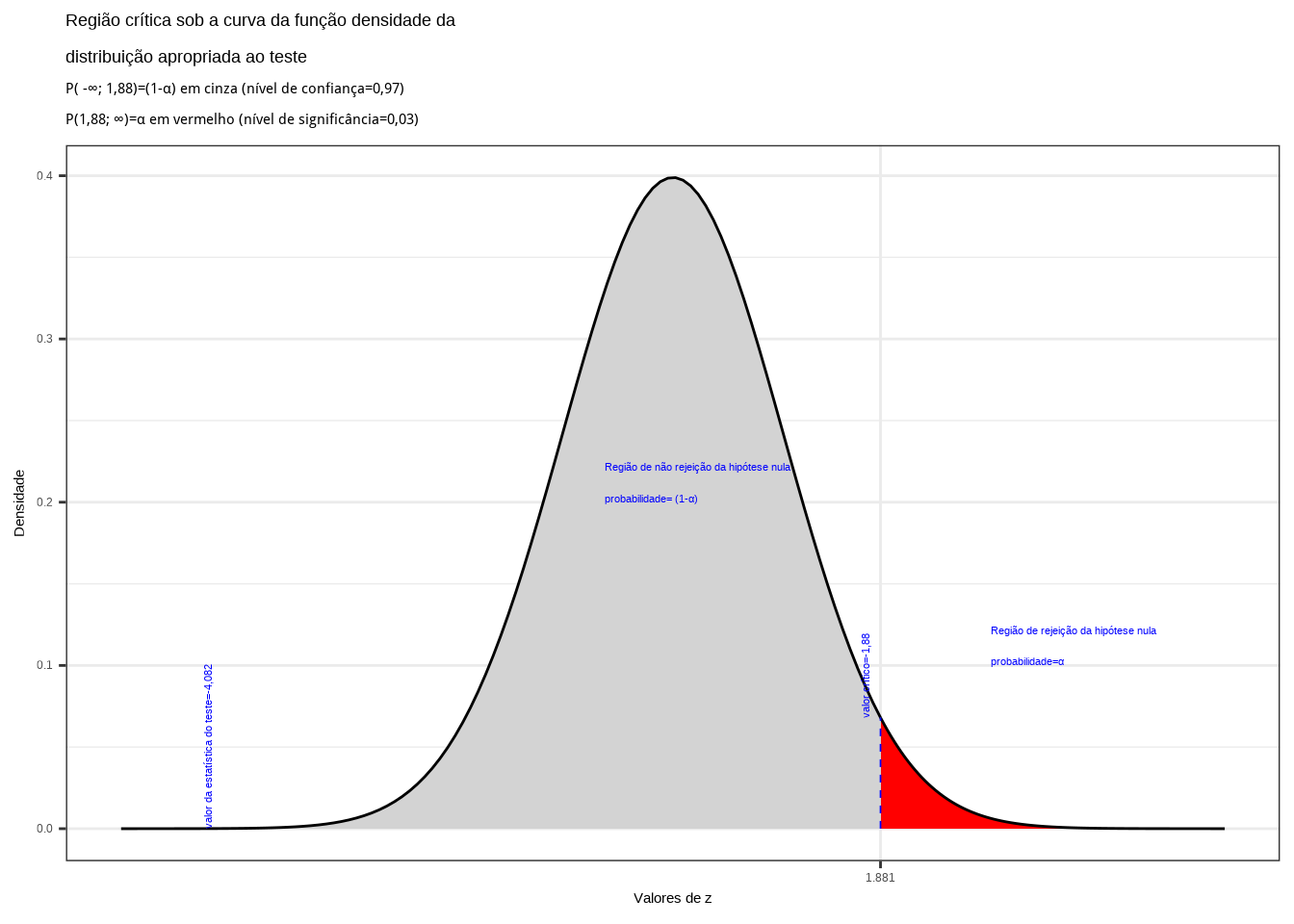

Teste unilateral à direita (tipo: maior que)

\[ \begin{cases} H_{0}: \mu \le 5\\ H_{1}: \mu > 5\\ \end{cases} \]

Iremos verificar se a informação amostral obtida nos permite rejeitar a hipótese nula que afirma ser a média igual ou menor a 5, fazendo então valer a hipótese alternativa que afirma ser a média maior que 5.

Da tabela ``t’’ de Student obtemos o valor crítico monocaudal: \(|{t}_{tab_(\alpha, (n-1))}|=1,86\). Pelo cálculo a estatística do teste é \(t_{calc}=-2,02\).

alfa=0.95

prob_desejada=alfa

df=8

t_desejado=round(qt(prob_desejada,df ),4)

d_desejada=dt(t_desejado,df)

t_calculado=-2

d_calculado=dt(t_calculado,df)

ggplot(NULL, aes(c(-4,4))) +

geom_area(stat = "function",

fun = dt,

args=list(df),

fill = "lightgrey",

xlim = c(-4, t_desejado),

colour="black") +

geom_area(stat = "function",

fun = dt,

args=list(df),

fill = "red",

xlim = c(t_desejado,4),

colour="black") +

scale_y_continuous(name="Densidade") +

scale_x_continuous(name="Valores de t", breaks = c(t_desejado)) +

labs(title=

"Regiões críticas sob a curva da função densidade da \ndistribuição apropriada ao teste",

subtitle = "P(-\U221e; 1,86)=(1-\u03b1) em cinza (nível de confiança=0,95) \nP(1,86; \U221e)= \u03b1 em vermelho (nível de significância=0,05) ")+

geom_segment(aes(x = t_desejado, y = 0, xend = t_desejado, yend = d_desejada), color="blue", lty=2, lwd=0.3)+

annotate(geom="text", x=t_desejado-3, y=0.1, label="Região de não rejeição da hipótese nula \nprobabilidade=\u03b1", angle=0, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=t_desejado, y=0.1, label="Região de rejeição da hipótese nula \nprobabilidade= (1-\u03b1)", angle=0, vjust=0, hjust=0, color="blue",size=3)+

geom_segment(aes(x = t_calculado, y = 0, xend = t_calculado, yend = d_calculado), color="blue", lty=2, lwd=0.3)+

annotate(geom="text", x=t_calculado-0.1, y=d_calculado, label="valor da estatística do teste=-2.02", angle=90, vjust=0, hjust=0, color="blue",size=3)+

theme_bw()

Figure 11.16: Região de rejeição da hipótese nula para o teste unilateral à direita (tipo: maior que) realizado: a região de não rejeição da hipótese nula (região de não significância do teste) está delimitada pelo valor crítico da estatística do teste: \(t_{crit} = 1,86\). O valor calculado da estatística (\(t_{calc}=-2,02\)) situa-se na faixa de não significância do teste, não possibilitando a rejeição da hipótese nula sob aquele nível de confiança

Conclusão: sob um nível de confiança de confiança de 95%, face aos dados trazidos à análise não podemos rejeitar a hipótese de que a média seja inferior a 5 (Figura 11.16).

Caso estabelecêssemos um nível de confiança \((1-\alpha) \ge 0,9611277\) (ou tivéssemos uma informação amostral \(\stackrel{-}{x} \ge 5.919361\)), a hipótese nula seria rejeitada: a média populacional é maior que 5.

# Dados do problema

n=9

media_amostral=4

var_amostral=2.2

media_populacao=5

alfa=0.95

# Estatística de teste

t=(media_amostral - media_populacao) / sqrt(var_amostral / n)

# Graus de liberdade

df=n - 1

# Valor-p à direita

p_valor=pt(-t, df)

# Decisão e conclusão

if (p_valor < alfa) {

cat("Os dados amostrais trazidos à análise nos permitem rejeitar, sob o nível de significância estabelecido de", alfa ,"de se cometer um erro do tipo I, a hipótese nula (H0) que afirma ser a média populacional menor ou igual a", media_populacao,".A média populacional é maior que",media_populacao,"." )

} else {

cat("Os dados amostrais trazidos à análise não nos permitem rejeitar, sob o nível de confiança de", 1-alfa ,",a hipótese nula (H0). A média populacional é menor ou igual a", media_populacao,".")

}## Os dados amostrais trazidos à análise não nos permitem rejeitar, sob o nível de confiança de 0.05 ,a hipótese nula (H0). A média populacional é menor ou igual a 5 .

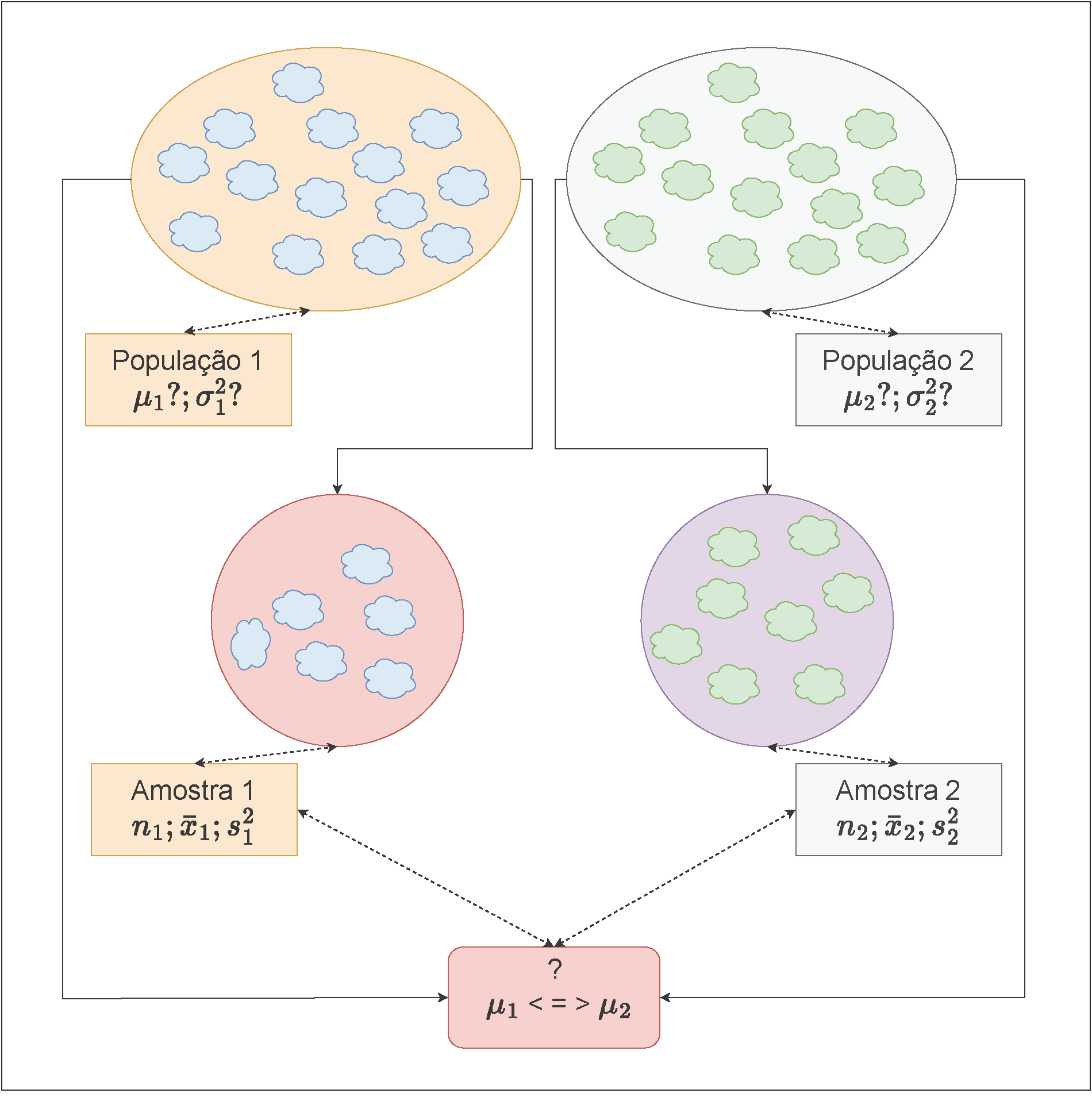

11.9 Teste de hipóteses para as médias (\(\mu_{1};\mu_{2}\)) de duas populações Normais independentes

Figure 11.17: Visão esquemática das amostras de duas populações

Pelo Teorema Limite Central, para tamanhos amostrais \(n\) suficientemente grandes a média amostral \(\stackrel{-}{X}\) tem distribuição aproximadamente Normal, com média \(\mu\) e variância \(\frac{\sigma^{2}}{n}\), independente da distribuição da população, onde \(\mu\) e \(\sigma^{2}\) são a média e a variância populacionais.

- grandes: \(n \geq 30 (40)\); e

- pequenas: \(n < 30\).

Situações possíveis:

- Variâncias populacionais conhecidas ou não conhecidas mas com amostras de grande tamanho;

- Variâncias populacionais desconhecidas:

- Variâncias populacionais admitidas iguais; ou,

- Variâncias populacionais quaisquer.

- Variâncias populacionais admitidas iguais; ou,

Os valores assumidos pelas características de nosso interesse nas populações são tais que:

\[ X_{1} \sim \mathcal{N}(\mu_{1}; \sigma^{2}_{1}) \]

e

\[ X_{2} \sim \mathcal{N}(\mu_{2}; \sigma^{2}_{2}) \]

Ao se extrair duas amostras, os valores amostrais assumidos por essas características serão duas variáveis aleatórias tais que:

\[ \stackrel{-}{X}_{1} \sim \mathcal{N} (\mu_{1}\frac{\sigma^{2}_{1}}{n_{1}}) \]

e

\[ \stackrel{-}{X}_{2} \sim \mathcal{N} (\mu_{2};\frac{\sigma^{2}_{2}}{n_{2}}). \]

É de nosso particular interesse definir uma variável aleatória expressa como a diferença das variáveis \(\stackrel{-}{X}_{1}\) e \(\stackrel{-}{X}_{2}\).

Segue-se assim (por serem independentes) que

\[ \stackrel{-}{X}_{1}-\stackrel{-}{X}_{2} \sim \mathcal{N} (\mu_{1}-\mu_{2}; \frac{\sigma^{2}_{1}}{n_{1}} + \frac{\sigma^{2}_{2}}{n_{2}}) . \]

11.9.1 As estruturas possíveis dos testes de hipóteses relacionados às suas médias serão:

Teste bilateral (tipo: diferente de)

\[

\begin{cases}

H_{0}:(\mu_{1} - \mu_{2}) = \Delta_{0} \\

H_{1}:(\mu_{1} - \mu_{2}) \ne \Delta_{0} \\

\end{cases}

\]

Teste unilateral à esquerda (tipo: menor que)

\[ \begin{cases} H_{0}: (\mu_{1} - \mu_{2}) \ge \Delta_{0}\\ H_{1}: (\mu_{1} - \mu_{2}) < \Delta_{0}\\ \end{cases} \]

Teste unilateral à direita (tipo: maior que)

\[ \begin{cases} H_{0}: (\mu_{1} - \mu_{2}) \le \Delta_{0}\\ H_{1}: (\mu_{1} - \mu_{2}) > \Delta_{0}\\ \end{cases} \]

Os valores assumidos pelas diferenças amostrais são tais que:

\[ \frac{(\stackrel{-}{X}_{1}-\stackrel{-}{X}_{2}) - \Delta_{0}}{\sqrt{\frac{\sigma^{2}_{1}}{n_{1}} + \frac{\sigma^{2}_{2}}{n_{2}}}} \sim \mathcal{N} (0,1) \]

para

- amostras Normais: \(n_{1}\) e \(n_{2}\) qualquer;

- amostras sob outras distribuições, desde que: \(n_{1}\) e \(n_{2} \ge 30(40)\):

- \({Z}_{tab\left(\frac{\alpha }{2}\right)}\) ou \({Z}_{tab\left(\alpha \right)}\): valores da distribuição Normal padronizada para o nível de significância pretendido no teste (bilateral ou unilateral); e,

- \(Z_{calc} = \frac{(\stackrel{-}{X}_{1} - \stackrel{-}{X}_{2})-\Delta_{0}}{\sqrt{\frac{\sigma^{2}_{1}}{n_{1}}+\frac{\sigma^{2}_{2}}{n_{2}}}} \sim \mathcal{N}(0,1)\)

em que:

- \(\Delta_{0}\) é o valor inferido à diferença das médias populacionais \(\mu_{1}\) e \(\mu_{2}\), usualmente 0 (igualdade);

- \(\sigma_{1}^{2}\) é a variância da população 1;

- \(\sigma_{2}^{2}\) é a variância da população 2;

- \(\stackrel{-}{X}_{1}, n_{1}\) são a média e o tamanho da amostra 1; e,

- \(\stackrel{-}{X}_{2}, n_{2}\) são a média e o tamanho da amostra 2.

11.9.2 Testes de hipóteses para as médias de duas populações com variâncias conhecidas (ou não conhecidas mas o tamanho das amostras é grande)

Probabilidade dos intervalos de confiança para os testes de hipóteses com o uso da estatística Z (\(Z \sim \mathcal{N}(0,1)\)):

- Teste de hipóteses bilateral (tipo: diferente de):

\[\begin{align*} P[\left|Z_{calc}\right| \le {Z}_{tab\left(\frac{\alpha }{2}\right)}|\mu_{1}=\mu_{2}] & =(1-\alpha)\\ P(-{Z}_{tab\left(\frac{\alpha }{2}\right)} \le Z_{calc} \le {Z}_{tab\left(\frac{\alpha }{2}\right)}) & = (1-\alpha)\\ \end{align*}\]

- Teste de hipóteses unilateral à esquerda (tipo: menor que):

\[\begin{align*} P[Z_{calc} \ge -{Z}_{tab\left(\alpha \right)}|\mu_{1} \ge \mu_{2}] & =(1-\alpha) \\ P( Z_{calc} \ge -{Z}_{tab\left(\alpha \right)}) & = (1-\alpha) \\ \end{align*}\]

- Teste de hipóteses unilateral à direita (tipo maior que):

\[\begin{align*} P[Z_{calc} \le {Z}_{tab\left(\alpha \right)}|\mu_{1} \le \mu_{2}] & =(1-\alpha) \\ P( Z_{calc} \le {Z}_{tab\left(\alpha \right)}) & = (1-\alpha) \\ \end{align*}\]

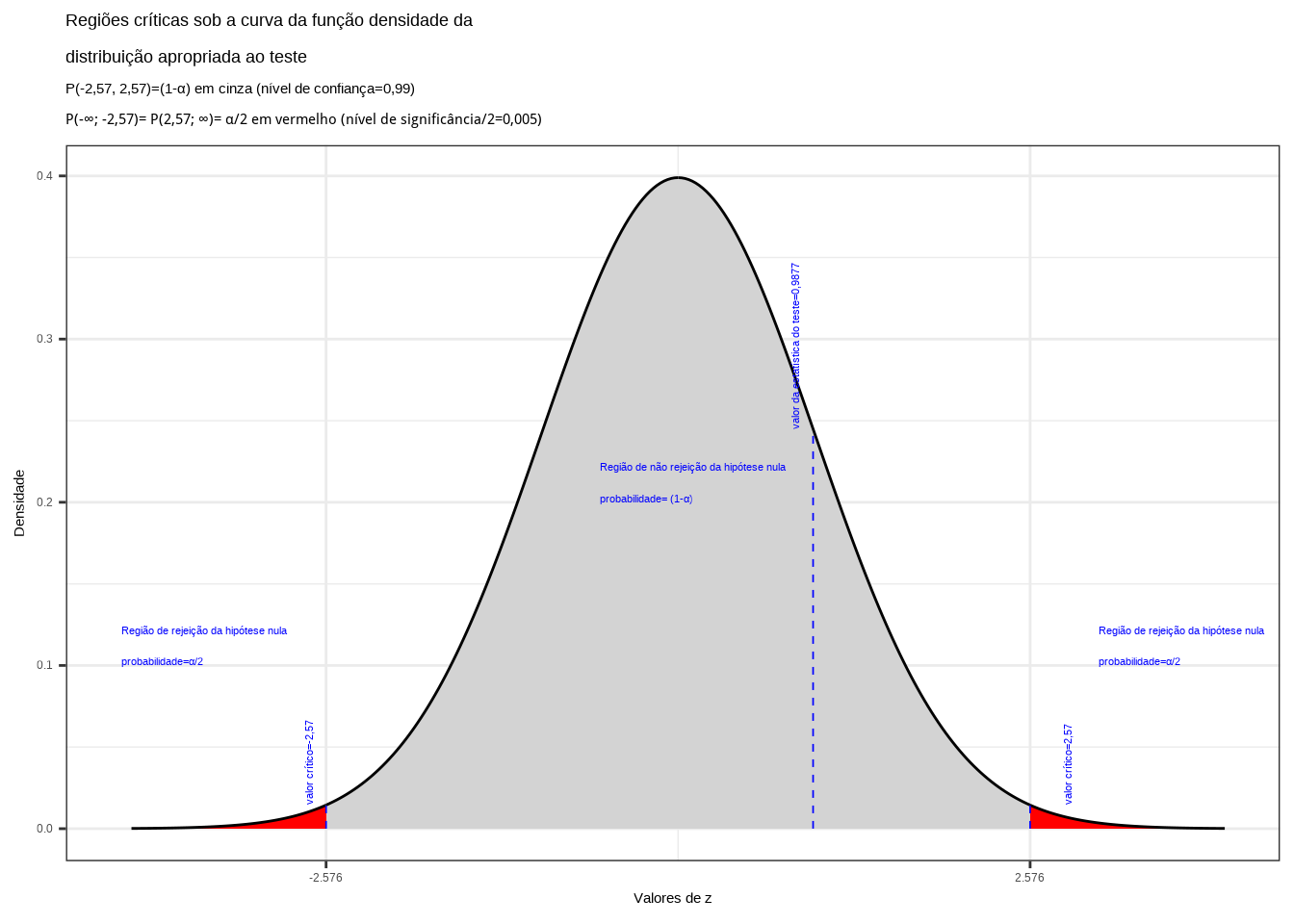

Nas figuras 11.8, 11.9 e 11.10 observam-se:

- as regiões de rejeição da hipótese nula (subdivididas nos dois ou em apenas um dos lados) sob a curva da função densidade de probabilidade da distribuição adequada ao teste com probabilidades iguais ao nível de significância \(\alpha\) ;

- a região de não rejeição da hipótese nula (delimitada à esquerda e à direita ou apenas em um dos lados) com probabilidade igual ao nível de confiança \((1-\alpha)\); e,

- os valores críticos da estatística do teste.

Exemplo: Duas máquinas são usadas para encher garrafas plásticas com um volume líquido de 16oz. Os volumes de enchimento podem ser admitidos como normais, tendo desvios padrão iguais a \(\sigma_{1}=0,020\)oz e \(\sigma_{2}=0,025\)oz. O departamento de engenharia da fábrica deseja saber a um nível de significância de \(\alpha=0,01\) se ambas as máquinas enchem um mesmo volume e para isso coletou uma amostra de 10 garrafas enchidas por cada uma das máquinas cf. tabela abaixo:

| Máquina 01 | Máquina 02 | ||

|---|---|---|---|

| 16,03 | 16,01 | 16,02 | 16,03 |

| 16,04 | 15,96 | 15,97 | 16,04 |

| 16,05 | 15,98 | 15,96 | 16,02 |

| 16,05 | 16,02 | 16,01 | 16,01 |

| 16,02 | 15,99 | 15,99 | 16,00 |

As variâncias populacionais \(\sigma_{1}^{2}\) e \(\sigma_{2}^{2}\) são conhecidas e as populações seguem uma distribuição Normal. A estatística do teste é:

\[

Z_{calc} = \frac{(\stackrel{-}{X}_{1} - \stackrel{-}{X}_{2}) }{\sqrt{\frac{\sigma^{2}_{1}}{n_{1}}+\frac{\sigma^{2}_{2}}{n_{2}}}}

\]

tal que tal que Z (\(Z \sim \mathcal{N}(0,1)\)), em que:

- \(\mu_{1} , \mu_{2}\) são as médias das populações em teste;

- \(\sigma_{1}^{2}=0,020^{2}, \sigma_{2}^{2}=0,025^{2}\) são as variâncias das populações em teste;

- \(\stackrel{-}{x}_{1}=16,015, n_{1}=10\) são a média e o tamanho da amostra 1;

- \(\stackrel{-}{x}_{2}=16,005, n_{2}=10\) são a média e o tamanho da amostra 2; e,

- o nível de significância estabelecido para o teste é \(\alpha=0,01\).

O problema nos pede um teste bilateral (tipo: diferente de):

\[

\begin{cases}

H_{0}: (\mu_{1} - \mu_{2}) = 0 \\

H_{1}: (\mu_{1} - \mu_{2}) \ne 0 \\

\end{cases}

\]

Se \(z_{calc}\) for tal que:

\[ -{z}_{tab\left(\frac{\alpha }{2}\right)} \le z_{calc} \le {z}_{tab\left(\frac{\alpha }{2}\right)} \]

não se rejeita a hipótese nula sob o nível de signficância estabelecido. Da tabela da distribuição Normal padronziada obtemos o valor crítico bicaudal: \(|{Z}_{tab\left(\frac{\alpha }{2}\right)}|=2,57\). Pelo cálculo, a estatística do teste é \(z_{calc}=0,98773\).

alfa=0.01

prob_desejada1=alfa/2

z_desejado1=round(qnorm(prob_desejada1),4)

d_desejada1=dnorm(z_desejado1, 0, 1)

prob_desejada2=1-alfa/2

z_desejado2=round(qnorm(prob_desejada2),4)

d_desejada2=dnorm(z_desejado2, 0, 1)

z_calculado=0.98773

d_calculado=dnorm(z_calculado, 0, 1)

ggplot(NULL, aes(c(-4,4))) +

geom_area(stat = "function",

fun = dnorm,

fill = "red",

xlim = c(-4, z_desejado1),

colour="black") +

geom_area(stat = "function",

fun = dnorm,

fill = "lightgrey",

xlim = c(z_desejado1,0),

colour="black") +

geom_area(stat = "function",

fun = dnorm,

fill = "lightgrey",

xlim = c(0, z_desejado2),

colour="black") +

geom_area(stat = "function",

fun = dnorm,

fill = "red",

xlim = c(z_desejado2,4),

colour="black") +

scale_y_continuous(name="Densidade") +

scale_x_continuous(name="Valores de z", breaks = c(z_desejado1,z_desejado2)) +

labs(title=

"Regiões críticas sob a curva da função densidade da \ndistribuição apropriada ao teste",

subtitle = "P(-2,57, 2,57)=(1-\u03b1) em cinza (nível de confiança=0,99) \nP(-\U221e; -2,57)= P(2,57; \U221e)= \u03b1/2 em vermelho (nível de significância/2=0,005) ")+

geom_segment(aes(x = z_desejado1, y = 0, xend = z_desejado1, yend = d_desejada1), color="blue", lty=2, lwd=0.3)+

geom_segment(aes(x = z_desejado2, y = 0, xend = z_desejado2, yend = d_desejada2), color="blue", lty=2, lwd=0.3)+

annotate(geom="text", x=z_desejado1-0.1, y=d_desejada1, label="valor crítico=-2,57", angle=90, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=z_desejado2+0.3, y=d_desejada2, label="valor crítico=2,57", angle=90, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=z_desejado1-1.5, y=0.1, label="Região de rejeição da hipótese nula \nprobabilidade=\u03b1/2", angle=0, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=z_desejado2+0.5, y=0.1, label="Região de rejeição da hipótese nula \nprobabilidade=\u03b1/2", angle=0, vjust=0, hjust=0, color="blue",size=3)+

annotate(geom="text", x=z_desejado1+2, y=0.2, label="Região de não rejeição da hipótese nula \nprobabilidade= (1-\u03b1)", angle=0, vjust=0, hjust=0, color="blue",size=3)+

geom_segment(aes(x = z_calculado, y = 0, xend = z_calculado, yend = d_calculado), color="blue", lty=2, lwd=0.3)+

annotate(geom="text", x=z_calculado-0.1, y=d_calculado, label="valor da estatística do teste=0,9877", angle=90, vjust=0, hjust=0, color="blue",size=3)+

theme_bw()

Figure 11.18: Regiões de rejeição da hipótese nula para o teste bilateral (tipo: diferente de) realizado: a região de não rejeição da hipótese nula (região de não significância do teste) está delimitada pelos valores críticos da estatística do teste: \(z_{crit} =\pm 2,57\). O valor calculado da estatística (\(z_{calc}=0,987\)) não nos possibilita a rejeição da hipótese nula sob aquele nível de confiança