1.7 Estatística e machine learning : uma livre tradução deste link

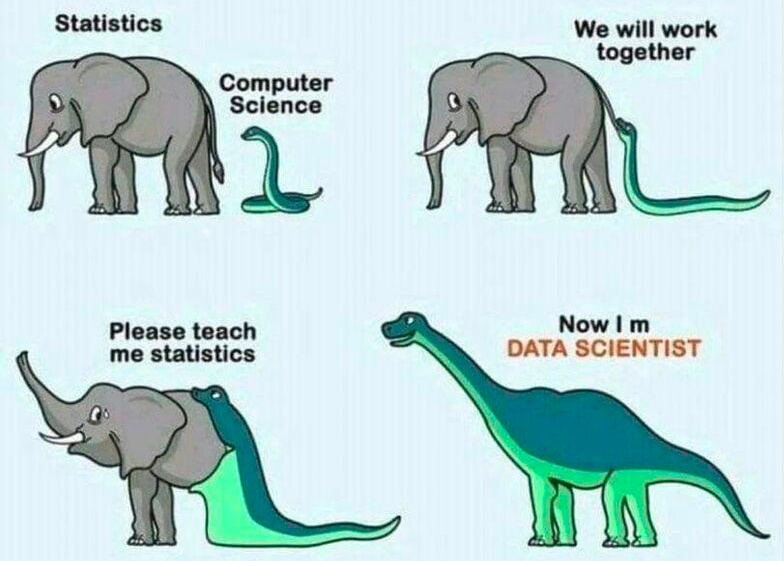

Figure 1.26: Autor: estatístico anônimo

Para se raciocinar rigorosamente sob incerteza, precisamos invocar a linguagem da probabilidade (Zhang et al. 2020). Qualquer modelo que não forneça a quantificação da incerteza associada ao seu resultado provavelmente produzirá uma imagem incompleta e potencialmente enganosa.

Embora este seja um consenso irrevogável na estatística, um equívoco comum, embora muito persistente, é que os algoritmos de machine learning geralmente carecem de formas adequadas de quantificar a incerteza.

Apesar do fato dos dois termos existirem em paralelo e serem indistintamente utilizados, a percepção de que algoritmos de machine learning e a estatística implicam um conjunto de técnicas não sobrepostas permanece viva, tanto entre profissionais como acadêmicos.

Isso é vividamente retratado pela declaração provocativa (e potencialmente irônica) de Brian D. Ripley de que “o aprendizado de máquina é estatística menos qualquer verificação de modelos e suposições” que ele fez durante a “useR! 2004”, conferência de Viena que serviu para ilustrar a diferença entre aprendizado de máquina e estatística.

Na verdade, a relação entre estatística e algoritmos de machine learning é artificialmente complicada por tais afirmações e, na melhor das hipóteses, isto é lamentável, pois implica numa distinção profunda e qualitativa entre as duas disciplinas (Januschowski et al. 2020). O artigo de Leo Breiman (2001) é uma exceção notável, pois propõe diferenciar os dois com base na cultura científica, e não apenas nos métodos.

Embora as abordagens discutidas em Breiman (2001) constituam uma divisão admissível do espaço de análise e modelação de dados, os avanços mais recentes tornaram gradualmente esta distinção menos clara.

Na verdade, a tendência atual de investigação tanto em estatística com algoritmos de machine learning gravita no sentido de aproximar ambas as disciplinas. Numa era de necessidade crescente de que os resultados dos modelos de previsão sejam transformados em conhecimentos explicáveis e confiáveis, este é um desenvolvimento extremamente promissor e encorajador, uma vez que ambas as disciplinas têm muito a aprender uma com a outra. Junto com Januschowski et al. (2020) , argumentamos que é mais construtivo procurar um terreno comum do que introduzir fronteiras artificiais.